Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

So funktioniert Smart Sifting von SageMaker

Das Ziel von SageMaker Smart Sifting besteht darin, Ihre Trainingsdaten während des Trainingsprozesses zu sichten und nur aussagekräftige Proben in das Modell einzuspeisen. Während eines typischen Trainings mit PyTorch werden Daten iterativ stapelweise vom PyTorch DataLoader

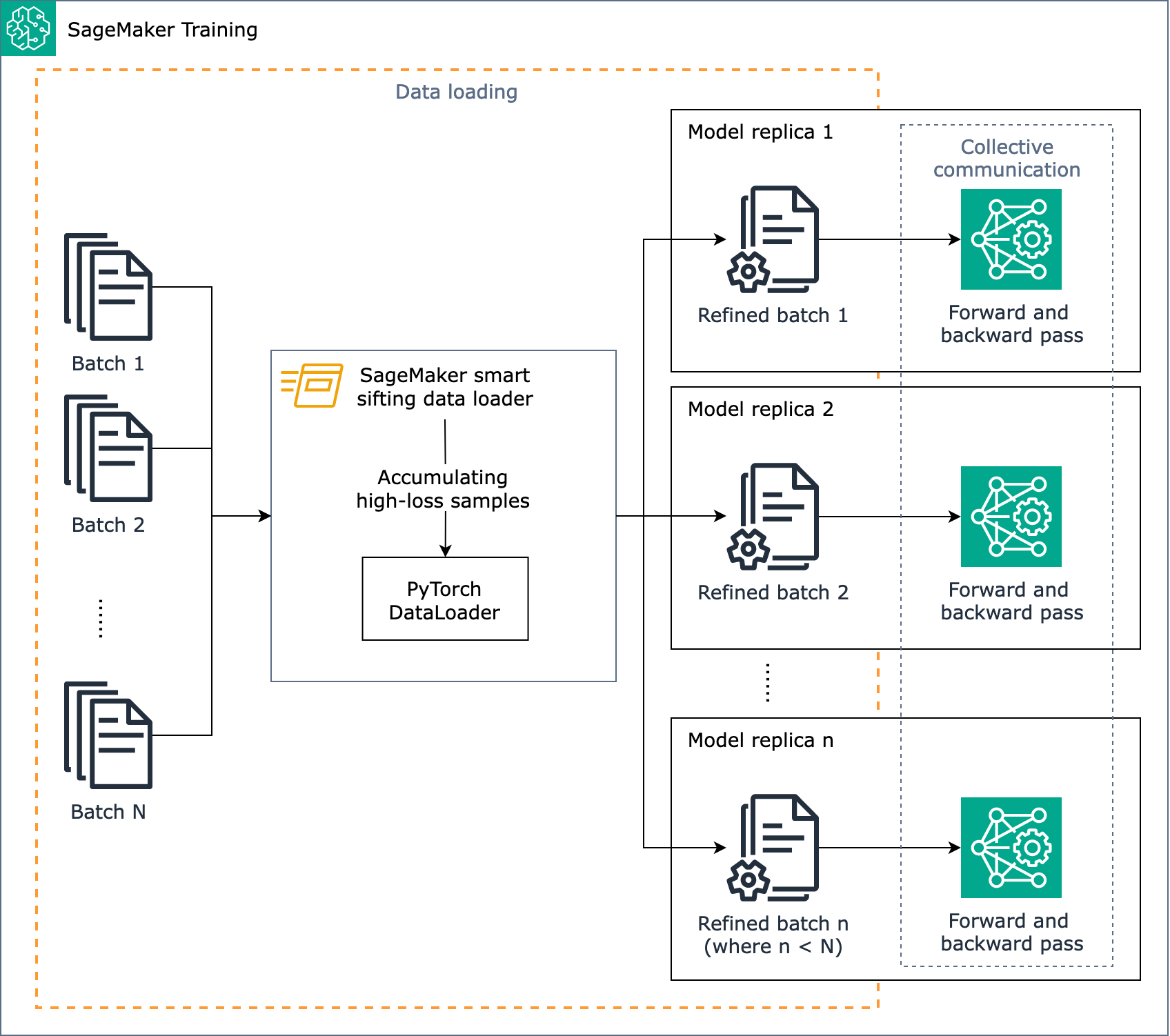

Das folgende Diagramm zeigt einen Überblick über den Aufbau des Smart-Sifting-Algorithmus von SageMaker.

SageMaker Smart Sifting wird während des Trainings ausgeführt, wenn Daten geladen werden. Der Smart-Sifting-Algorithmus von SageMaker führt eine Verlustberechnung für die Batches durch und sortiert Daten, die zu keinen Verbesserungen führen, vor dem Vorwärts- und Rückwärtsdurchlauf jeder Iteration heraus. Der verfeinerte Datenstapel wird dann für den Vorwärts- und Rückwärtsdurchlauf verwendet.

Anmerkung

Beim intelligenten Sichten von Daten auf SageMaker AI werden zusätzliche Vorwärtsdurchläufe verwendet, um Ihre Trainingsdaten zu analysieren und zu filtern. Im Gegenzug gibt es weniger Rückwärtsdurchläufe, da Daten mit geringerer Aussagekraft aus Ihrem Trainingsjob ausgeschlossen werden. Aus diesem Grund führt Smart Sifting bei Modellen mit langen oder aufwändigen Rückwärtsdurchläufen zu den größten Effizienzsteigerungen. Dauert der Vorwärtsdurchlauf Ihres Modells jedoch länger als der Rückwärtsdurchlauf, kann der Mehraufwand die Gesamttrainingszeit erhöhen. Um zu messen, wie viel Zeit für jeden Durchlauf aufgewendet wird, können Sie einen Pilot-Trainingsjob ausführen und Protokolle sammeln, in denen die Dauer der Prozesse aufgezeichnet wird. Erwägen Sie auch die Verwendung von SageMaker Profiler mit Tools zur Profilerstellung und einer Benutzeroberflächenanwendung. Weitere Informationen hierzu finden Sie unter Amazon SageMaker Profiler.

Smart Sifting von SageMaker funktioniert für PyTorch-basierte Trainingsjobs mit klassischer verteilter Datenparallelität, bei der Modellreplikate auf jedem GPU-Worker erstellt werden und AllReduce ausgeführt wird. Es funktioniert mit PyTorch DDP und der verteilten Datenparallelitätsbibliothek von SageMaker AI.