Évaluation des performances de votre modèle

Amazon SageMaker Canvas fournit une vue d'ensemble et des informations de notation pour les différents types de modèles. Le score de votre modèle peut vous aider à déterminer son degré de précision lorsqu'il effectue des prédictions. Les informations de notation supplémentaires peuvent vous aider à quantifier les différences entre les valeurs réelles et prédites.

Pour consulter l'analyse de votre modèle, procédez comme suit :

-

Ouvrez l’application SageMaker Canvas.

-

Dans le panneau de navigation de gauche, choisissez Mes modèles.

-

Choisissez le modèle que vous avez créé.

-

Dans le panneau de navigation supérieur, choisissez l'onglet Analyser.

-

Dans l'onglet Analyser, vous pouvez consulter la vue d'ensemble et les informations de notation de votre modèle.

Les sections suivantes expliquent comment interpréter la notation pour chaque type de modèle.

Évaluation des modèles de prédiction catégorielle

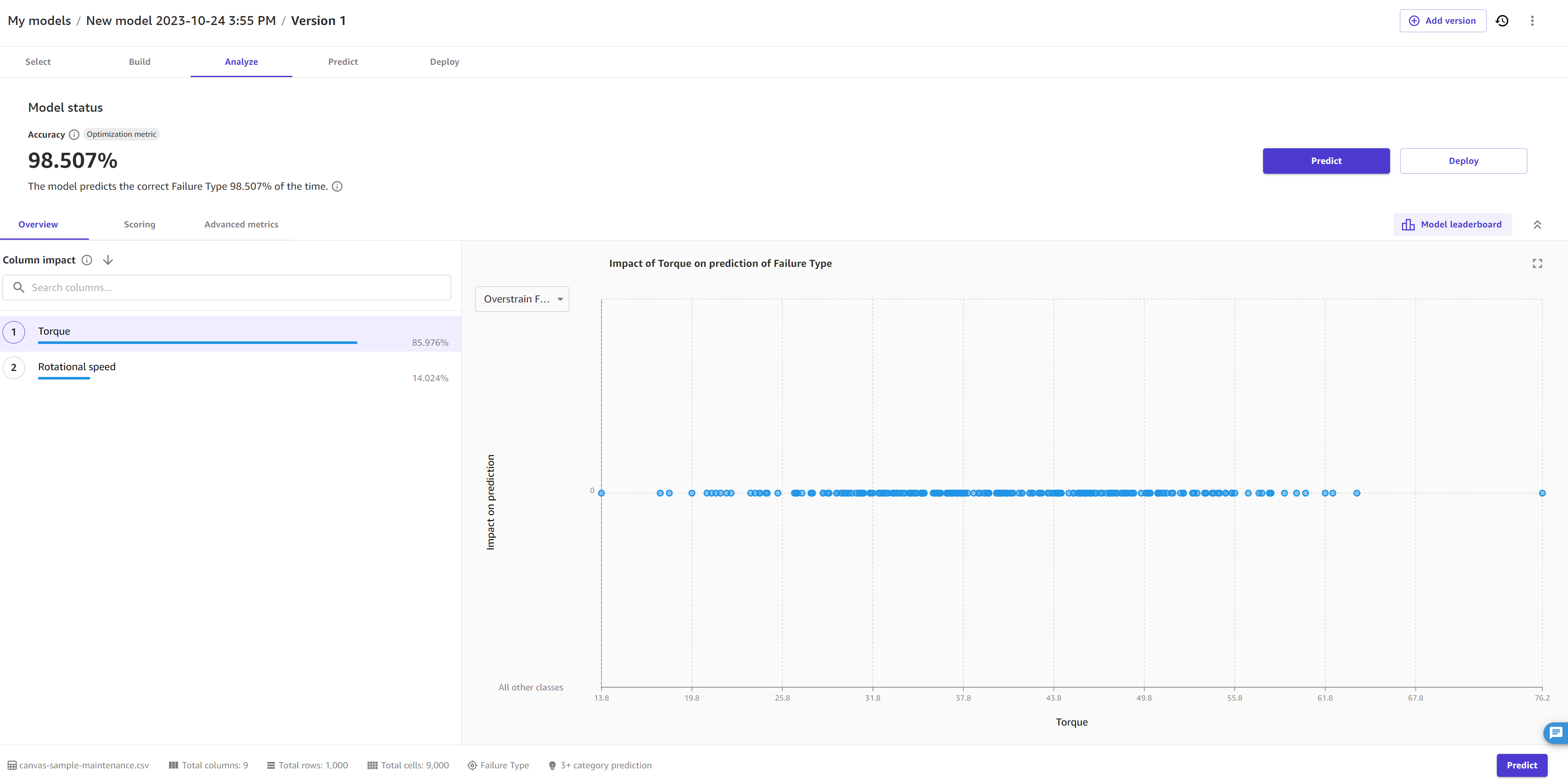

L'onglet Vue d'ensemble indique l'impact de chaque colonne. Column impact (Impact de colonne) est un score en pourcentage indiquant le poids que représente une colonne dans la réalisation des prédictions par rapport aux autres colonnes. Pour un impact de colonne de 25 %, Canvas estime la prédiction à 25 % pour la colonne et à 75 % pour les autres colonnes.

La capture d’écran suivante illustre le score de Précision du modèle, ainsi que la Métrique d’optimisation, qui est la métrique que vous choisissez d’optimiser lors de la création du modèle. Dans ce cas, la métrique d’optimisation est l’exactitude. Vous pouvez spécifier une autre métrique d’optimisation si vous créez une nouvelle version de votre modèle.

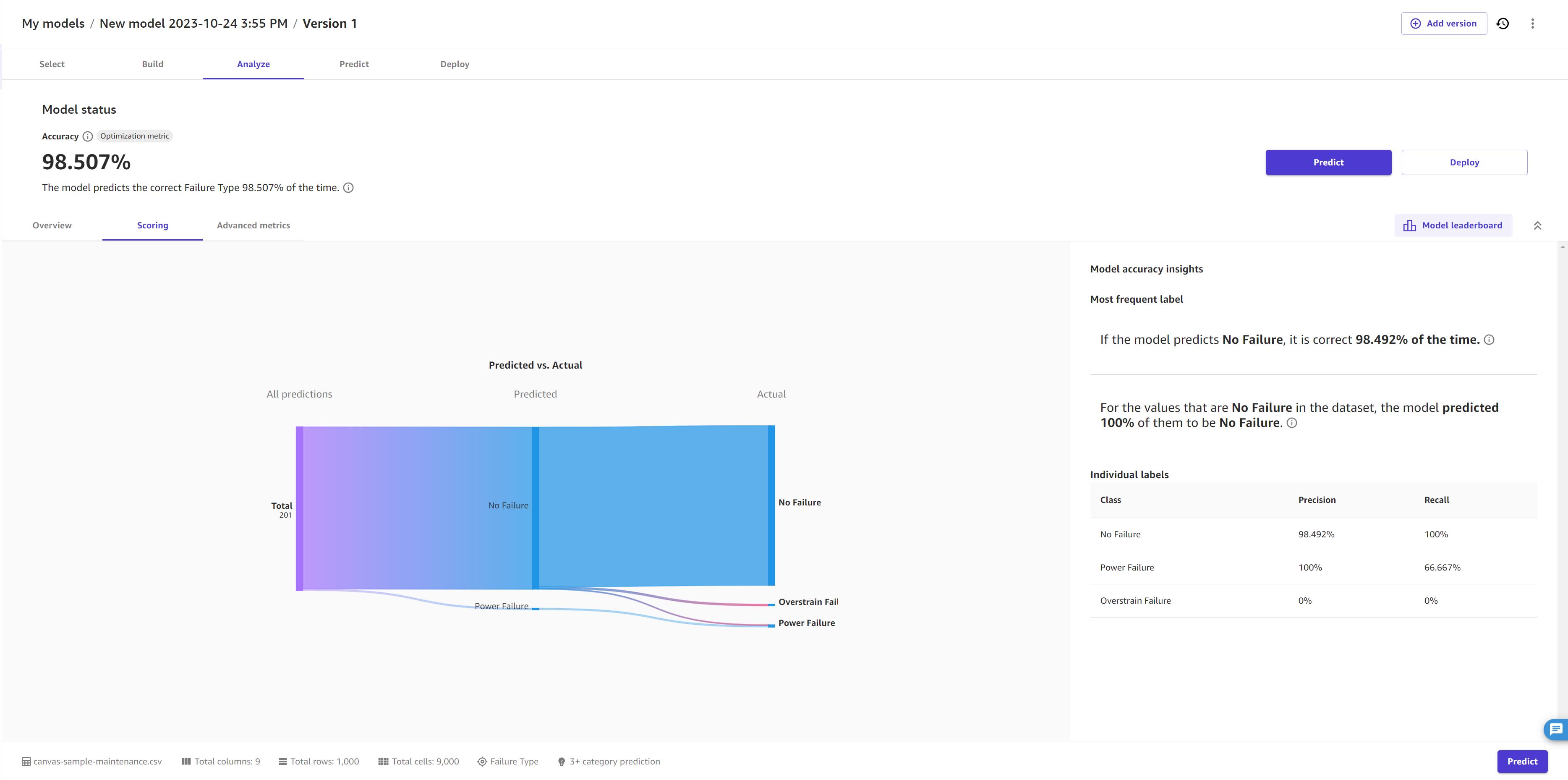

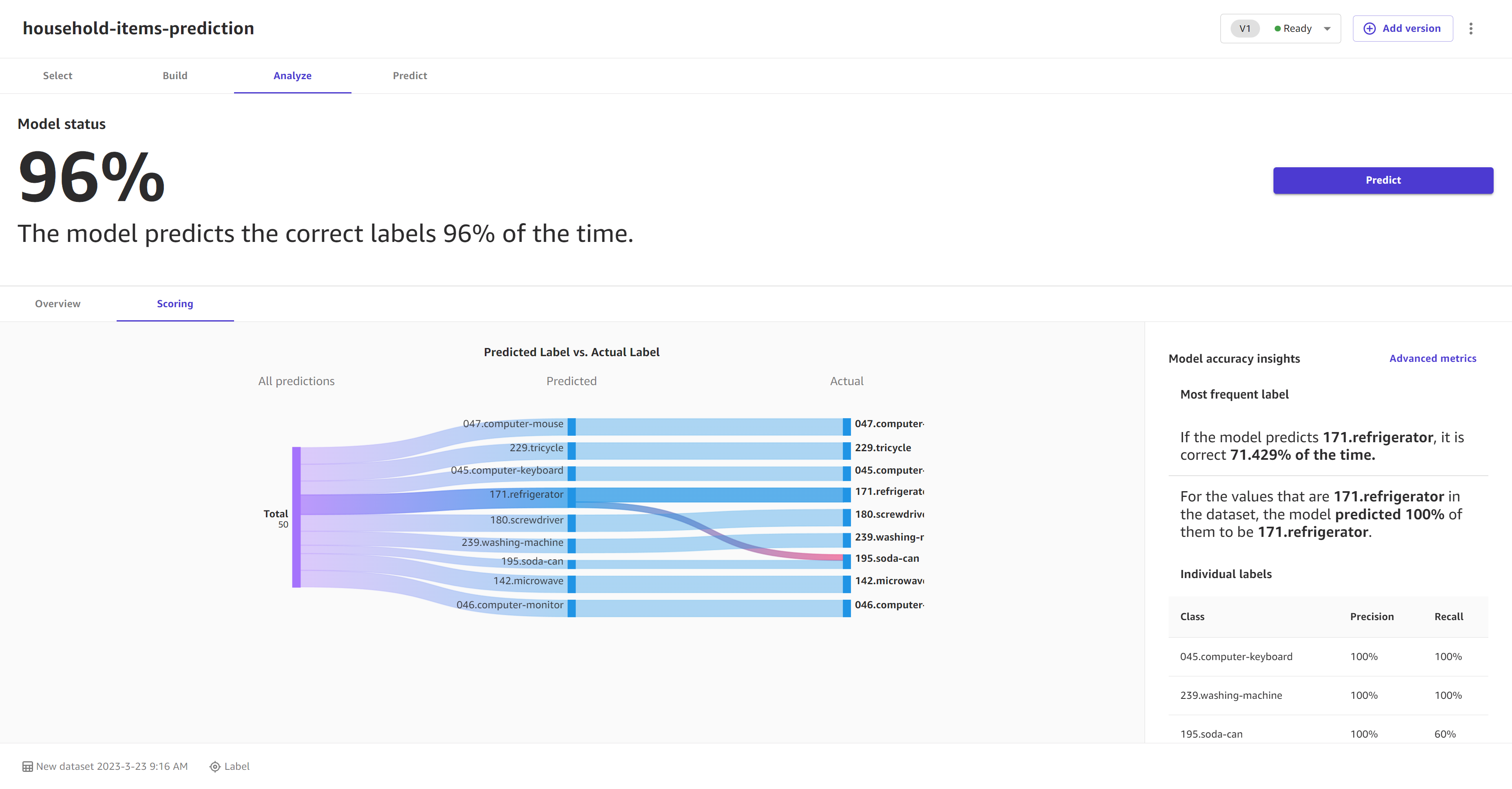

L'onglet Notation d'un modèle de prédiction catégorielle vous permet de visualiser toutes les prédictions. Les segments de ligne s’étendent à partir de la gauche de la page, indiquant toutes les prédictions effectuées par le modèle. Au milieu de la page, les segments de ligne convergent sur un segment perpendiculaire pour indiquer la proportion de chaque prédiction par rapport à une seule catégorie. À partir de la catégorie prédite, les segments se ramifient vers la catégorie réelle. Vous pouvez avoir une idée visuelle de la précision des prédictions en suivant chaque segment de ligne, de la catégorie prédite à la catégorie réelle.

L’image suivante montre un exemple de la section Notation pour un modèle de prédiction à 3 catégories ou plus.

Vous pouvez également consulter l’onglet Métriques avancées pour obtenir des informations plus détaillées sur les performances de votre modèle, telles que les métriques avancées, les diagrammes de densité d’erreurs ou les matrices de confusion. Pour en apprendre davantage sur l’onglet Métriques avancées, consultez Utiliser des métriques avancées dans vos analyses.

Évaluation des modèles de prédiction numérique

L'onglet Vue d'ensemble indique l'impact de chaque colonne. Column impact (Impact de colonne) est un score en pourcentage indiquant le poids que représente une colonne dans la réalisation des prédictions par rapport aux autres colonnes. Pour un impact de colonne de 25 %, Canvas estime la prédiction à 25 % pour la colonne et à 75 % pour les autres colonnes.

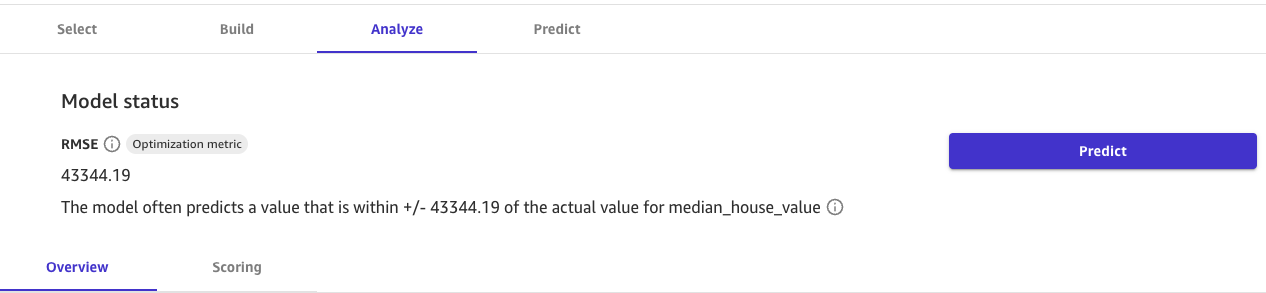

La capture d'écran suivante illustre le score RMSE du modèle dans l'onglet Vue d'ensemble, qui dans ce cas est la Métrique d'optimisation. La Métrique d'optimisation est la métrique que vous choisissez d'optimiser lors de la création du modèle. Vous pouvez spécifier une autre métrique d'optimisation si vous créez une nouvelle version de votre modèle.

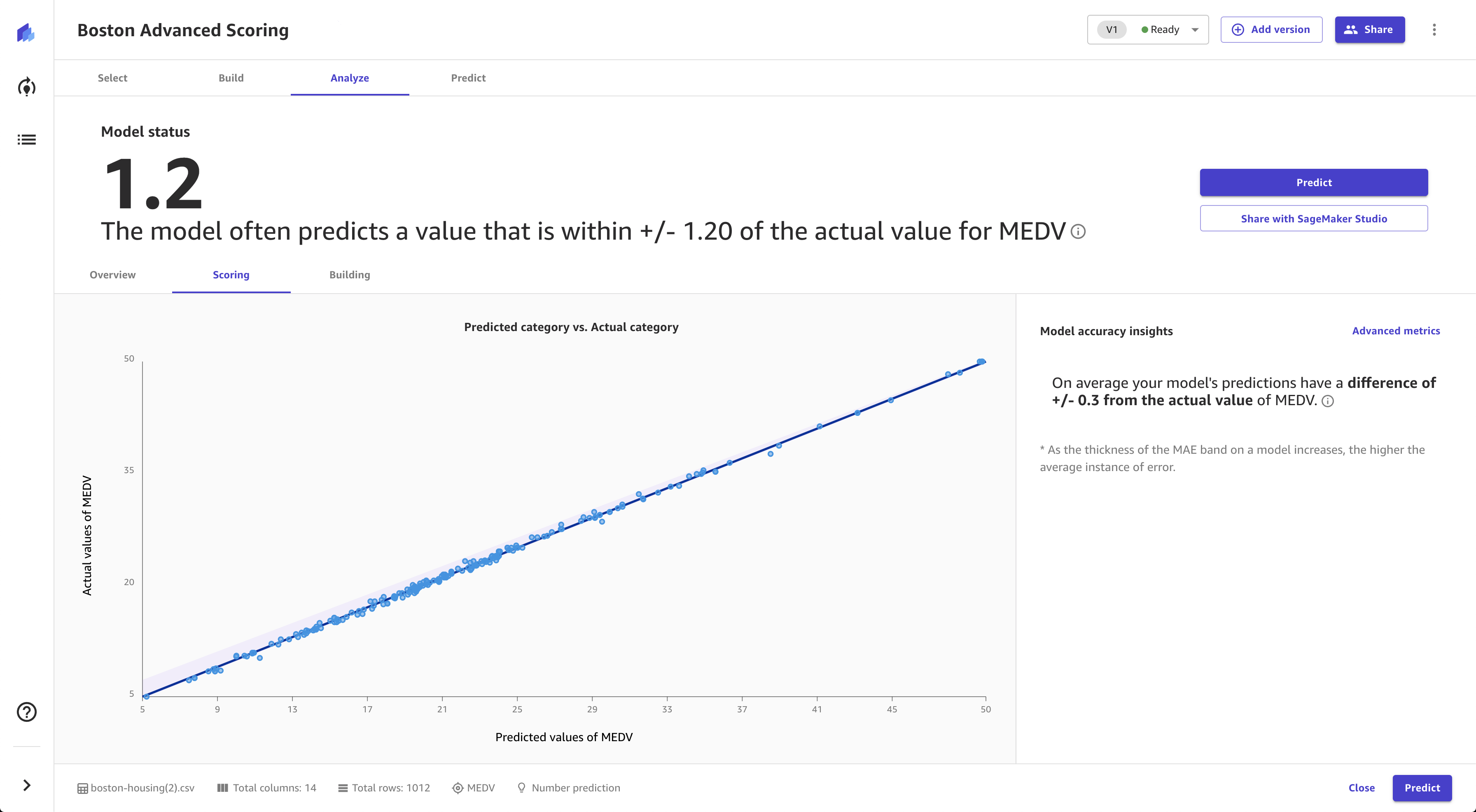

L'onglet Notation de la prédiction numérique montre une ligne indiquant la valeur prédite du modèle par rapport aux données utilisées pour effectuer les prédictions. Généralement, les valeurs de la prédiction numérique sont +/- la valeur RMSE (erreur quadratique moyenne racine). La valeur prédite par le modèle se situe souvent dans la plage du RMSE. La largeur de la bande violette autour de la ligne indique la plage RMSE. Les valeurs prédites se situent souvent dans la plage.

L’image suivante illustre une section Scoring (Notation) de prédiction numérique.

Vous pouvez également consulter l’onglet Métriques avancées pour obtenir des informations plus détaillées sur les performances de votre modèle, telles que les métriques avancées, les diagrammes de densité d’erreurs ou les matrices de confusion. Pour en apprendre davantage sur l’onglet Métriques avancées, consultez Utiliser des métriques avancées dans vos analyses.

Évaluation des modèles de prévision de séries temporelles

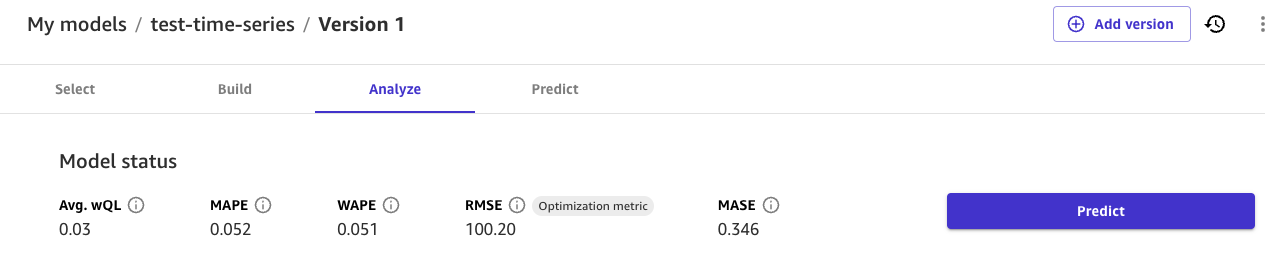

La page Analyser des modèles de prévision de séries temporelles affiche un aperçu des métriques du modèle. Vous pouvez pointer sur chaque métrique pour obtenir plus d’informations ou consulter Utiliser des métriques avancées dans vos analyses pour plus d’informations sur chaque métrique.

Dans la section Impact de colonne, vous pouvez voir le score de chaque colonne. Column impact (Impact de colonne) est un score en pourcentage indiquant le poids que représente une colonne dans la réalisation des prédictions par rapport aux autres colonnes. Pour un impact de colonne de 25 %, Canvas estime la prédiction à 25 % pour la colonne et à 75 % pour les autres colonnes.

La capture d'écran suivante illustre les scores des métriques de séries temporelles, ainsi que la Métrique d'optimisation, qui est la métrique que vous choisissez d'optimiser lors de la création du modèle. Dans ce cas, la Métrique d'optimisation est RMSE. Vous pouvez spécifier une autre métrique d’optimisation si vous créez une nouvelle version de votre modèle. Les scores de ces métriques sont tirés des résultats de vos rétro-tests, qui sont disponibles en téléchargement dans l’onglet Artefacts.

L’onglet Artefacts donne accès à plusieurs ressources clés que vous pouvez utiliser pour approfondir les performances de votre modèle et continuer à itérer sur celui-ci :

-

Fractionnement réorganisé d’entraînement et de validation : cette section inclut des liens vers les artefacts générés lorsque votre jeu de données a été divisé en jeux d’entraînement et de validation, ce qui vous permet de passer en revue la distribution des données et les biais potentiels.

-

Résultats des rétro-tests : cette section inclut un lien vers les valeurs prévues de votre jeu de données de validation, qui est utilisé pour générer des métriques d’exactitude et des données d’évaluation pour votre modèle.

-

Métriques d’exactitude : cette section répertorie les métriques avancées qui évaluent les performances de votre modèle, telles que l’erreur quadratique moyenne racine (RMSE). Pour plus d’informations sur cette métrique, consultez Mesures pour les prédictions de séries temporelles.

-

Rapport d’explicabilité : cette section fournit un lien pour télécharger le rapport d’explicabilité, qui offre un aperçu du processus décisionnel du modèle et de l’importance relative des colonnes d’entrée. Ce rapport peut vous aider à identifier les domaines susceptibles d’être améliorés.

Sur la page Analyser, vous pouvez également choisir le bouton Télécharger pour télécharger directement les résultats de rétro-test, les métriques d’exactitude et les artefacts du rapport d’explicabilité sur votre ordinateur local.

Évaluation des modèles de prédiction d’image

L'onglet Vue d'ensemble affiche les Performances par étiquette, qui vous donnent un score de précision global pour les images prédites pour chaque étiquette. Vous pouvez choisir une étiquette pour obtenir des détails sur celle-ci, tels que les images Correctement prédites et Incorrectement prédites pour l'étiquette.

Vous pouvez activer le bouton à bascule Carte thermique pour afficher une carte thermique pour chaque image. La carte thermique indique les zones d'intérêt qui ont le plus d'impact lorsque votre modèle effectue des prédictions. Pour plus d'informations sur les cartes thermiques et sur la façon de les utiliser pour améliorer votre modèle, choisissez l'icône Plus d'infos en regard du bouton à bascule Carte thermique.

L'onglet Notation des modèles de prédiction d'image à étiquette unique compare ce que le modèle a prédit en tant qu'étiquette avec l'étiquette réelle. Vous pouvez sélectionner jusqu'à 10 étiquettes à la fois. Vous pouvez modifier les étiquettes dans la visualisation en choisissant le menu déroulant des étiquettes et en sélectionnant ou en désélectionnant des étiquettes.

Vous pouvez également consulter les informations relatives à des étiquettes individuelles ou à des groupes d'étiquettes (les trois étiquettes présentant la précision la plus élevée ou la plus faible, par exemple) en choisissant le menu déroulant Afficher les scores pour dans la section Informations sur la précision du modèle.

La capture d’écran suivante illustre les informations de Notation d’un modèle de prédiction d’image à étiquette unique.

Évaluation des modèles de prédiction de texte

L'onglet Vue d'ensemble affiche les Performances par étiquette, qui vous donnent un score de précision global pour les passages de texte prédits pour chaque étiquette. Vous pouvez choisir une étiquette pour obtenir des détails sur celle-ci, tels que les passages Correctement prédits et Incorrectement prédits pour l'étiquette.

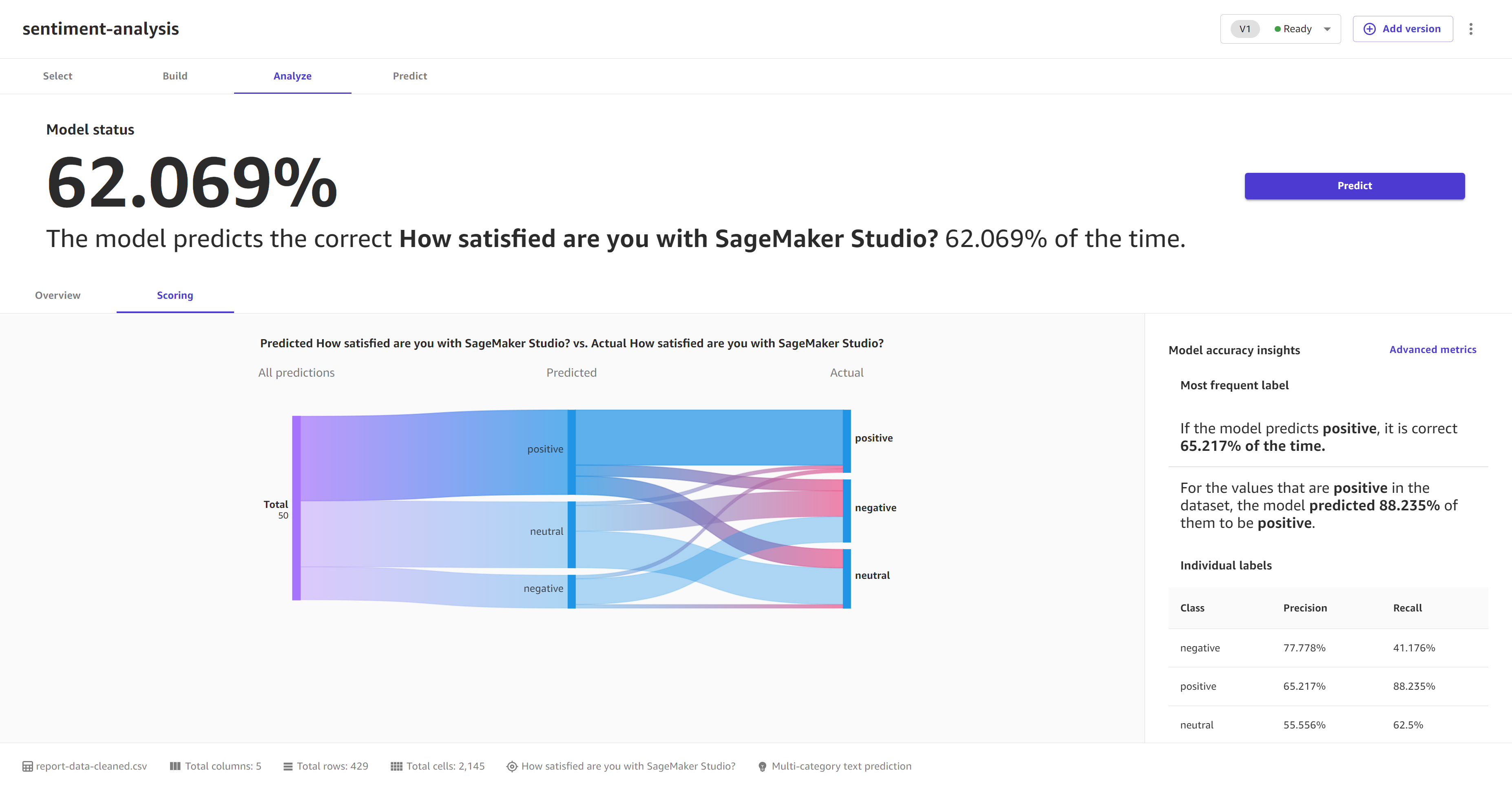

L'onglet Notation des modèles de prédiction de texte multi-catégories compare ce que le modèle a prédit en tant qu'étiquette avec l'étiquette réelle.

Dans la section Informations sur la précision du modèle, la Catégorie la plus fréquente indique la catégorie que le modèle a prédite le plus fréquemment et le degré de précision de ces prédictions. Si votre modèle prédit correctement une étiquette Positif 99 % du temps, vous pouvez être sûr que votre modèle est efficace pour prédire le sentiment positif dans un texte.

La capture d’écran suivante illustre les informations de Notation d’un modèle de prédiction de texte multi-catégories.