Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Explicabilité en ligne avec Clarify SageMaker

Ce guide explique comment configurer l'explicabilité en ligne avec SageMaker Clarify. Avec les points de terminaison d'inférence en temps réel de l' SageMaker IA, vous pouvez analyser l'explicabilité en temps réel et en continu. La fonction d'explicabilité en ligne s'inscrit dans la partie Déploiement vers la production du flux de travail Amazon SageMaker AI Machine Learning.

Comment fonctionne l'explicabilité en ligne Clarify

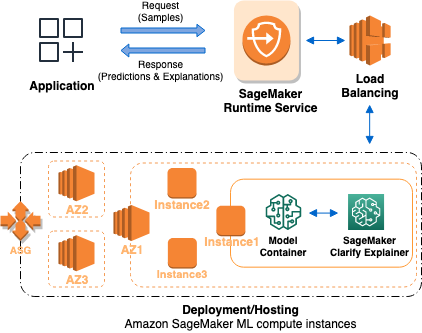

Le graphique suivant décrit l'architecture d' SageMaker intelligence artificielle permettant d'héberger un point de terminaison qui répond aux demandes d'explicabilité. Il décrit les interactions entre un point de terminaison, le conteneur du modèle et l'explicateur SageMaker Clarify.

Voici comment fonctionne l'explicabilité en ligne Clarify. L'application envoie une InvokeEndpoint demande de type REST au service SageMaker AI Runtime. Le service achemine cette demande vers un point de terminaison d' SageMaker IA pour obtenir des prédictions et des explications. Le service reçoit ensuite la réponse du point de terminaison. Enfin, le service renvoie la réponse à l'application.

Pour augmenter la disponibilité des terminaux, l' SageMaker IA tente automatiquement de distribuer les instances des points de terminaison dans plusieurs zones de disponibilité, en fonction du nombre d'instances indiqué dans la configuration des points de terminaison. Sur une instance de point de terminaison, lors d'une nouvelle demande d'explicabilité, l'explicateur SageMaker Clarify appelle le conteneur du modèle pour les prédictions. Ensuite, il calcule et renvoie les attributions de fonctionnalités.

Voici les quatre étapes pour créer un point de terminaison qui utilise l'explicabilité en ligne de SageMaker Clarify :

-

Créez une configuration de point de terminaison avec la configuration SageMaker explicative Clarify à l'aide de l'

CreateEndpointConfigAPI. -

Créez un point de terminaison et fournissez la configuration du point de terminaison à l' SageMaker IA à l'aide de l'

CreateEndpointAPI. Le service lance l'instance de calcul de machine learning et déploie le modèle tel que spécifié dans la configuration. -

Appelez le point de terminaison : une fois le point de terminaison en service, appelez l'API SageMaker AI Runtime

InvokeEndpointpour envoyer des demandes au point de terminaison. Le point de terminaison renvoie ensuite des explications et des prédictions.