Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Compilation d’un modèle (Console Amazon SageMaker AI)

Vous pouvez créer une tâche de compilation Amazon SageMaker Neo dans la console Amazon SageMaker AI.

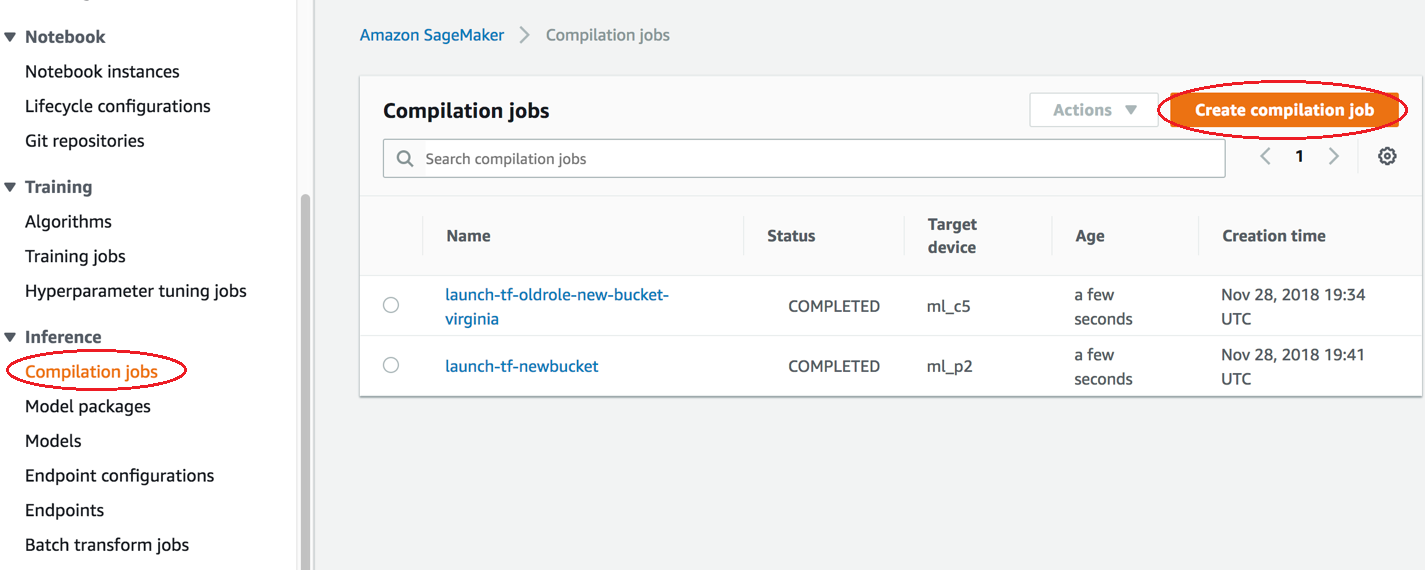

Dans la console Amazon SageMaker AI, choisissez Tâches de compilation, puis Créer une tâche de compilation.

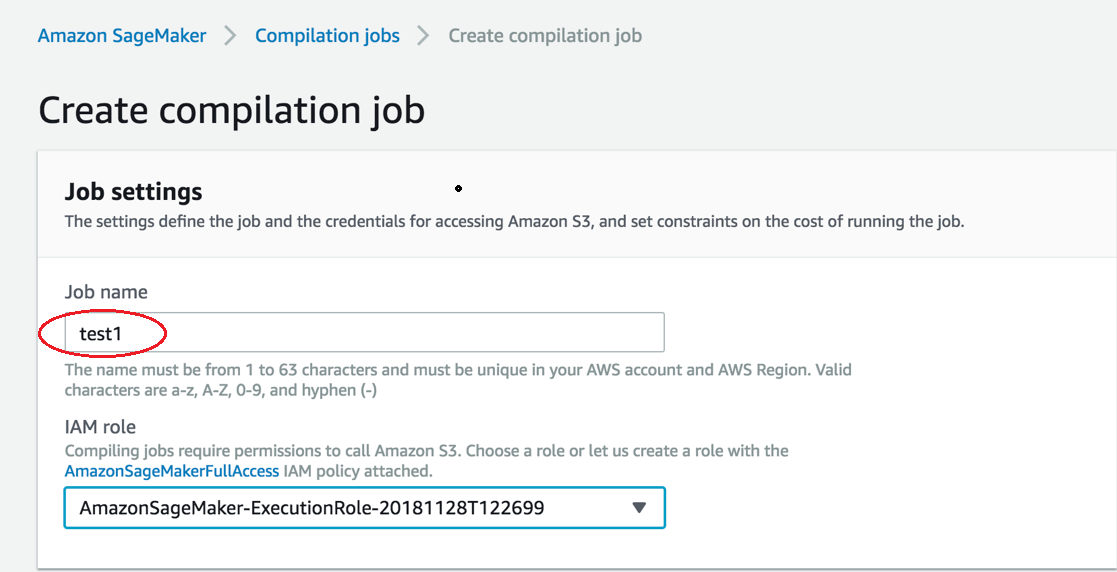

Sur la page Create compilation job (Créer une tâche de compilation), pour Job name (Nom de la tâche), saisissez un nom. Ensuite, sélectionnez un rôle IAM.

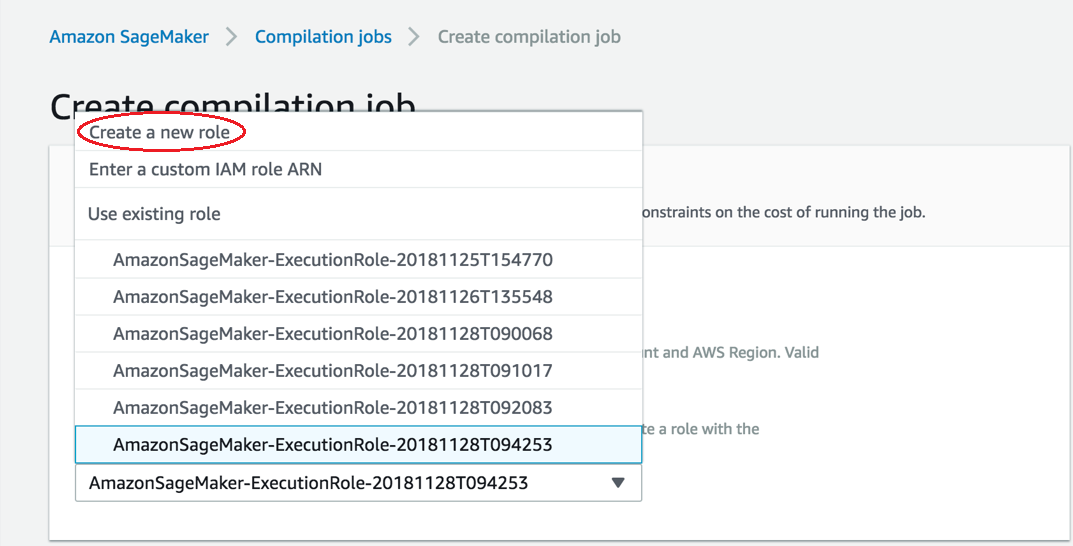

Si vous ne disposez pas de rôle IAM, choisissez Créer un rôle.

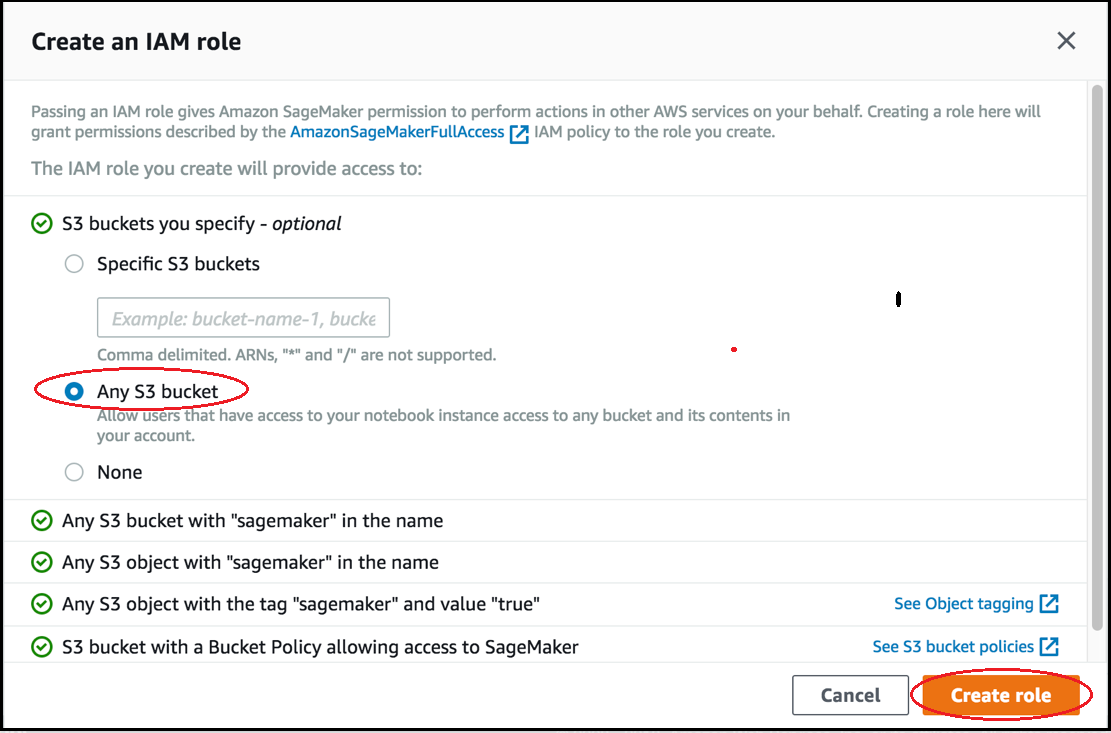

Sur la page Créer un rôle IAM, choisissez Tout compartiment S3, puis Créer un rôle.

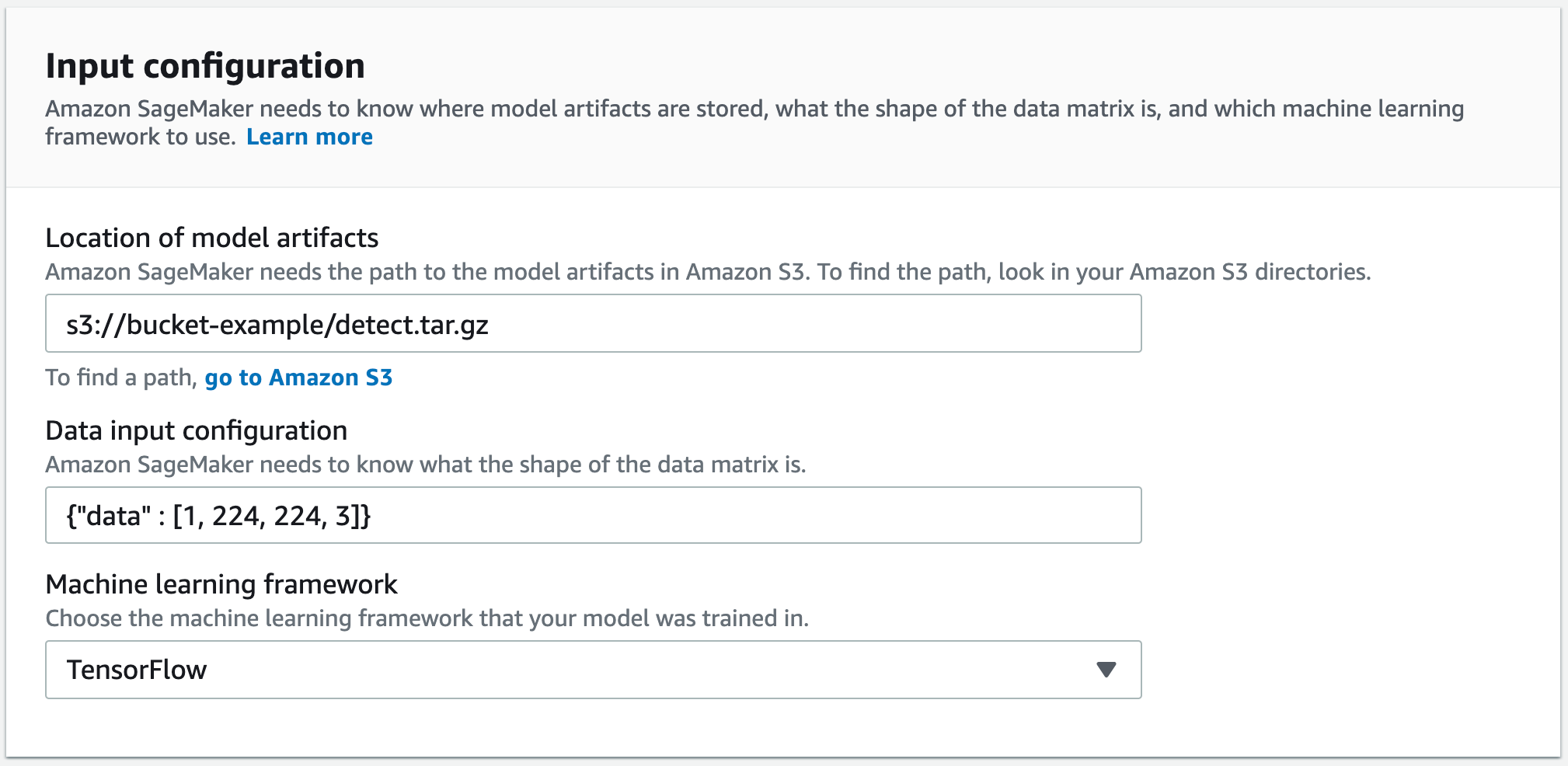

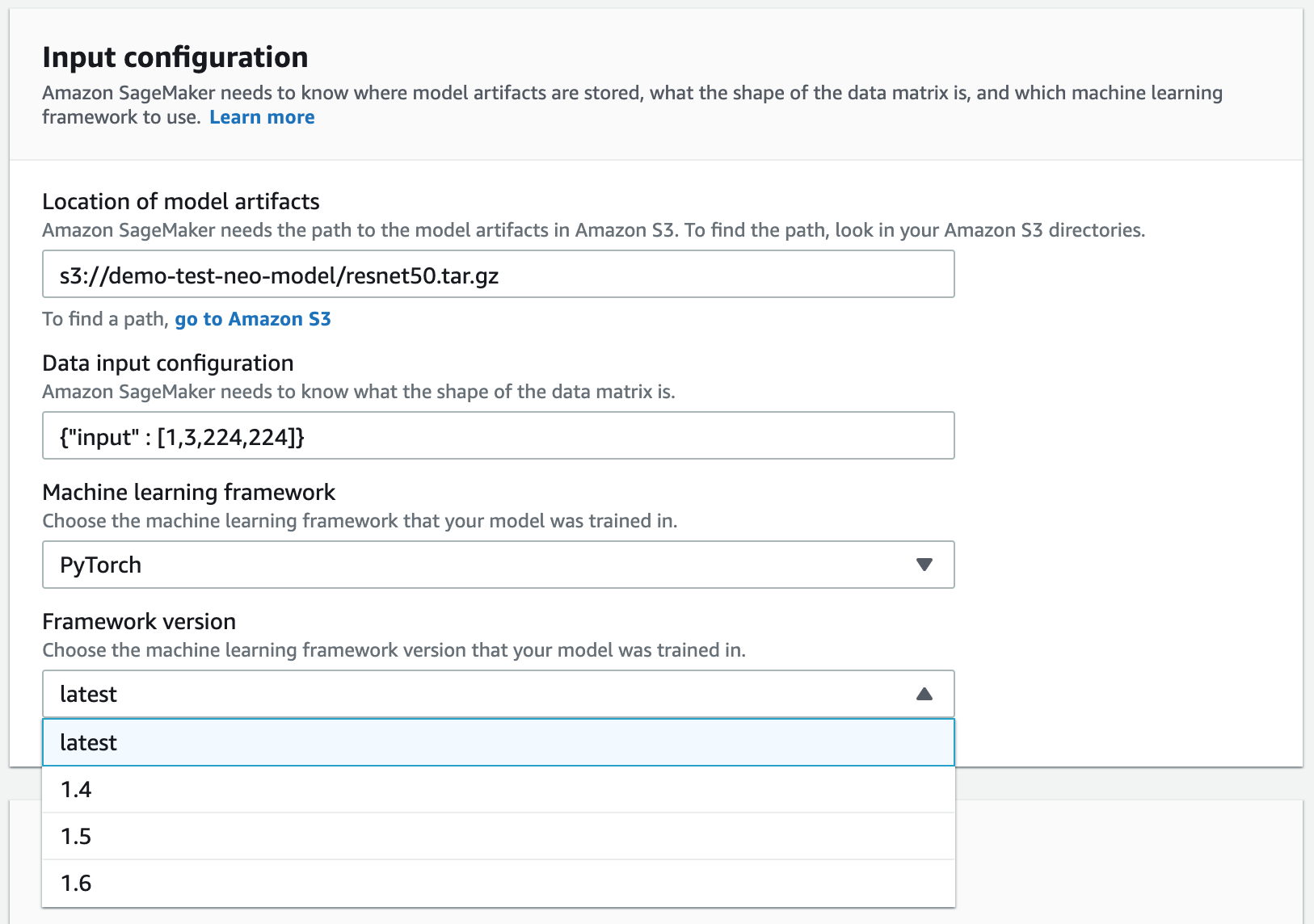

-

-

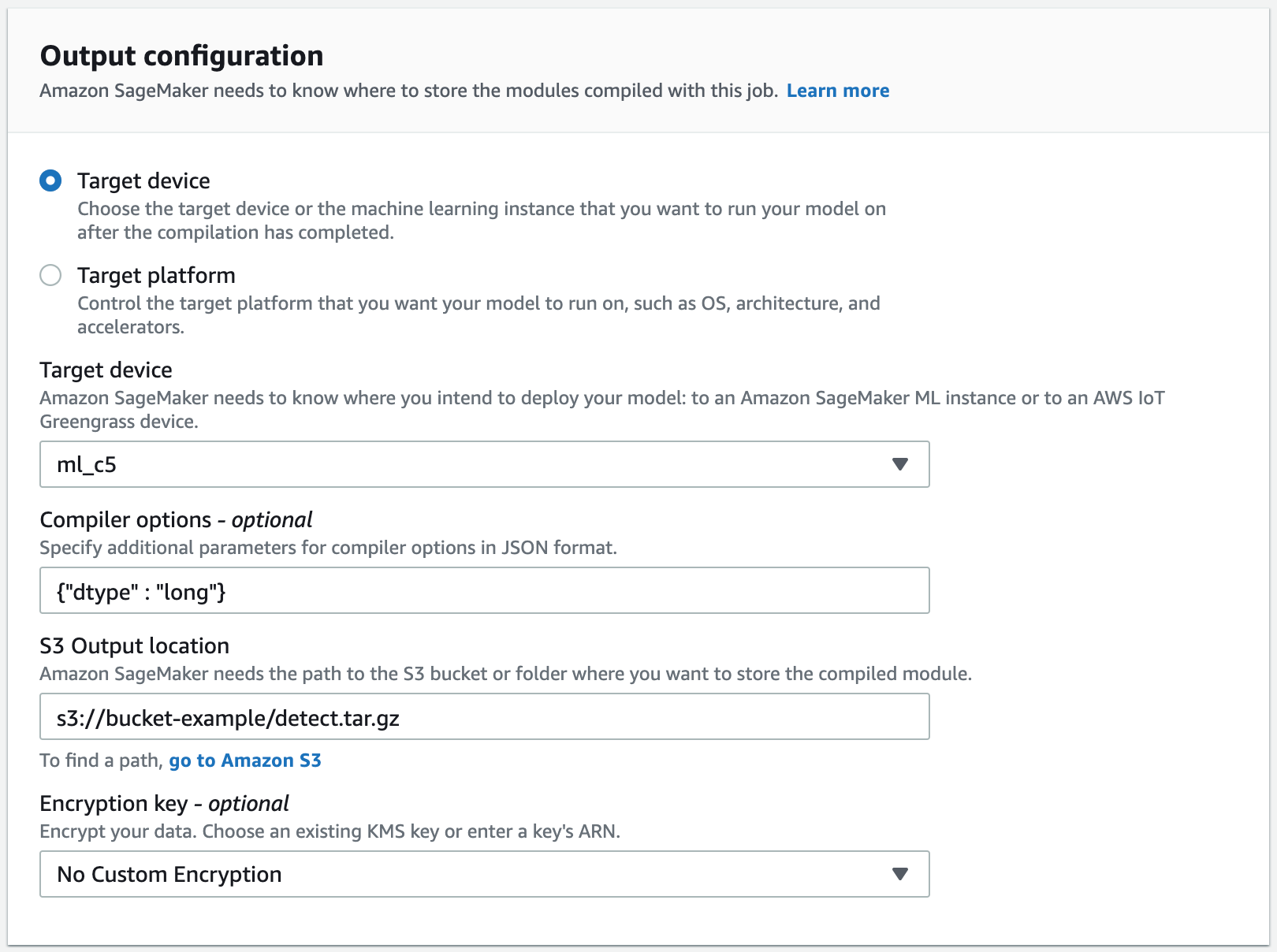

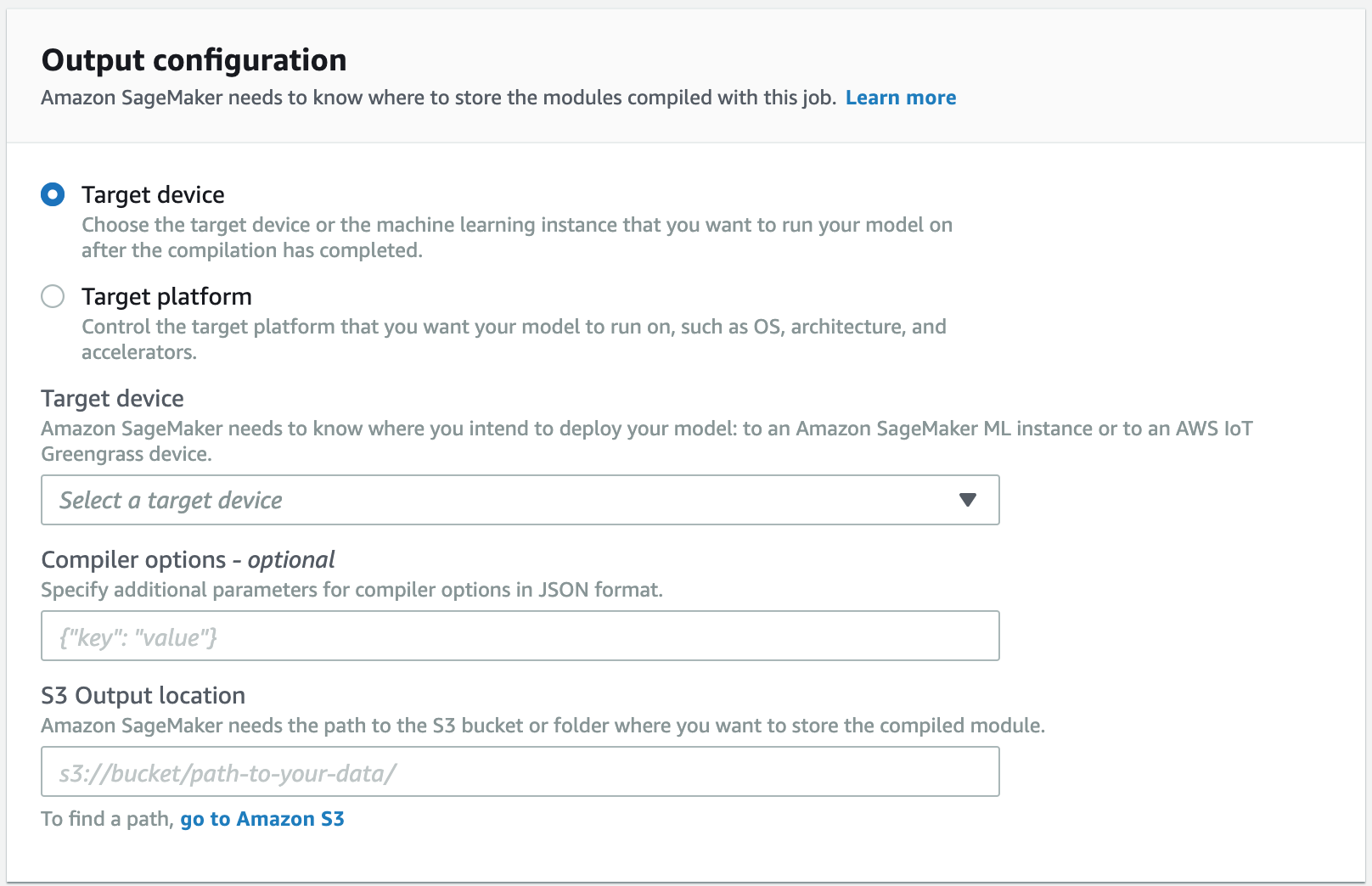

Accédez à la section Output configuration (Configuration de la sortie). Choisissez l'emplacement de déploiement de votre modèle. Vous pouvez déployer votre modèle sur un périphérique cible ou une plateforme cible. Les périphériques cibles comprennent les périphériques cloud et en périphérie. Les plateformes cibles font référence au système d'exploitation, à l'architecture et aux accélérateurs spécifiques sur lesquels votre modèle doit s'exécuter.

Pour S3 Output location (Emplacement de sortie S3), saisissez le chemin d'accès au compartiment S3 où vous voulez stocker le modèle compilé. Vous pouvez éventuellement ajouter des options de compilateur au format JSON dans la section Compiler options (Options de compilateur).

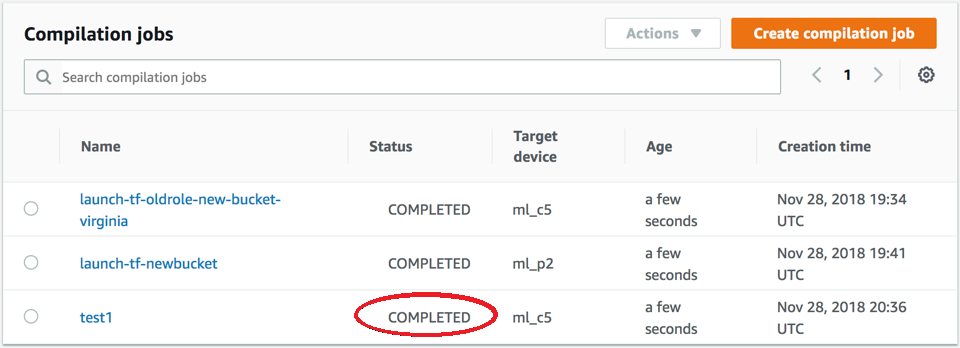

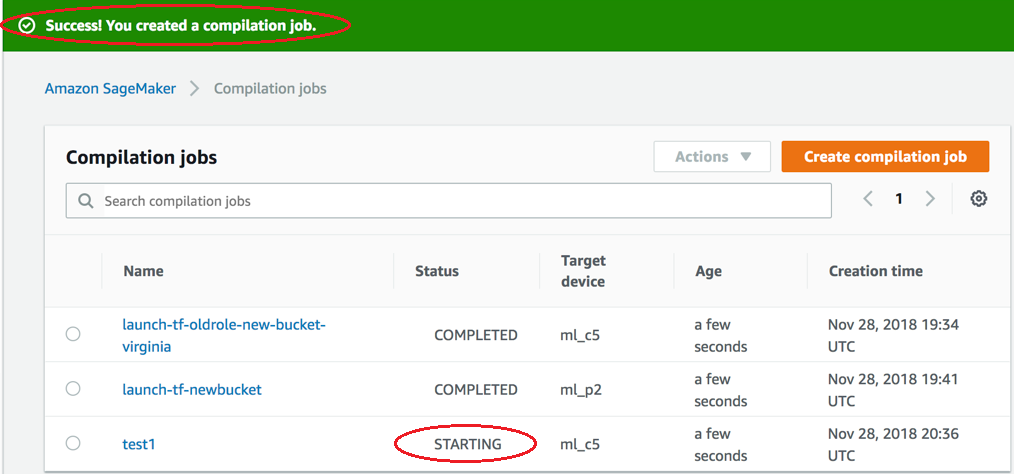

Vérifiez le statut de la tâche de compilation au démarrage. Le statut de la tâche se trouve en haut de la page Compilation Job (Tâche de compilation) comme le montre la capture d'écran ci-après. Vous pouvez également vérifier le statut de la tâche dans la colonne Status (Statut).

Vérifiez le statut de la tâche de compilation lorsque terminée. Vous pouvez vérifier le statut dans la colonne Status (Statut) comme le montre la capture d'écran ci-après.