Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Surveiller un essai miroir

Vous pouvez afficher les détails d’un essai miroir et le surveiller pendant qu’il est en cours ou une fois terminé. SageMaker AI présente un tableau de bord en temps réel qui compare les métriques opérationnelles telles que la latence du modèle et le taux d’erreur agrégé, des variantes de production et des variantes shadow.

Pour afficher les détails d’un essai individuel dans la console, procédez comme suit :

-

Sélectionnez l’essai que vous voulez surveiller dans la section Essai miroir de la page Essais miroirs.

-

Dans la liste déroulante Actions, choisissez Afficher. Une page de présentation contenant les détails de l’essai et un tableau de bord des métriques s’affiche.

La page de présentation comporte les trois sections suivantes.

- Récapitulatif

-

Cette section résume la progression et le statut de l’essai. Il affiche également les statistiques récapitulatives de la métrique choisie dans la liste déroulante Sélectionner une métrique de la sous-section Métriques. La capture d’écran suivante montre cette section.

Dans la capture d’écran précédente, les onglets Paramètres et Détails affichent les paramètres que vous avez sélectionnés et les détails que vous avez saisis lors de la création de l’essai.

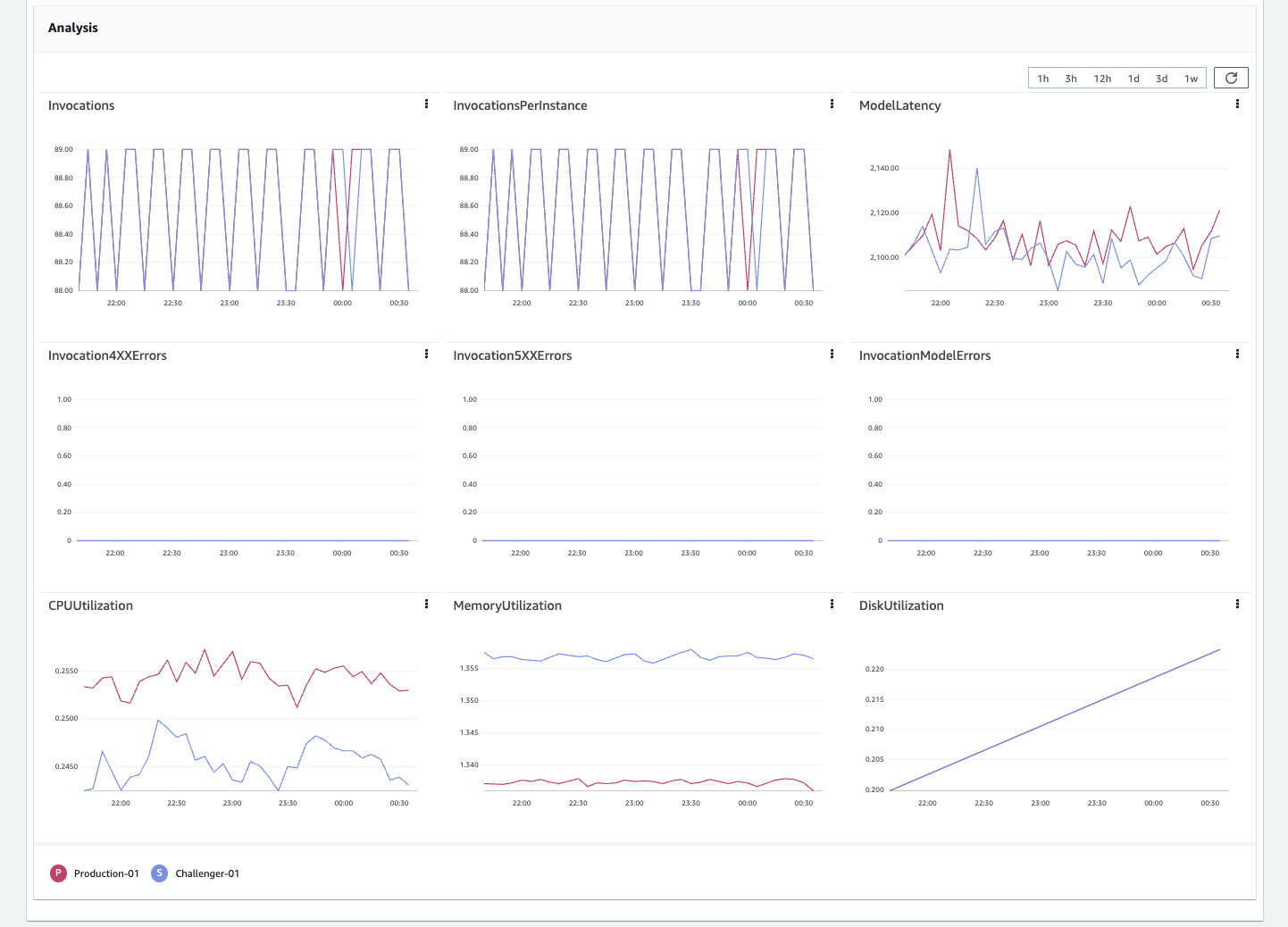

- Analyse

-

Cette section montre un tableau de bord de métriques avec des graphiques séparés pour les métriques suivantes :

InvocationsInvocationsPerInstanceModelLatencyInvocation4XXErrorsInvocation5XXErrorsInvocationModelErrorsCPUUtilizationMemoryUtilizationDiskUtilization

Les trois dernières métriques surveillent l’utilisation des ressources d’exécution du conteneur modèle. Les autres sont des métriques CloudWatch que vous pouvez utiliser pour analyser les performances de votre variante. En général, moins d’erreurs indiquent un modèle plus stable. Une latence plus faible indique soit un modèle plus rapide, soit une infrastructure plus rapide. Pour plus d’informations sur les métriques CloudWatch, consultez SageMaker Métriques d'invocation des terminaux AI. La capture d’écran suivante montre le tableau de bord des métriques.

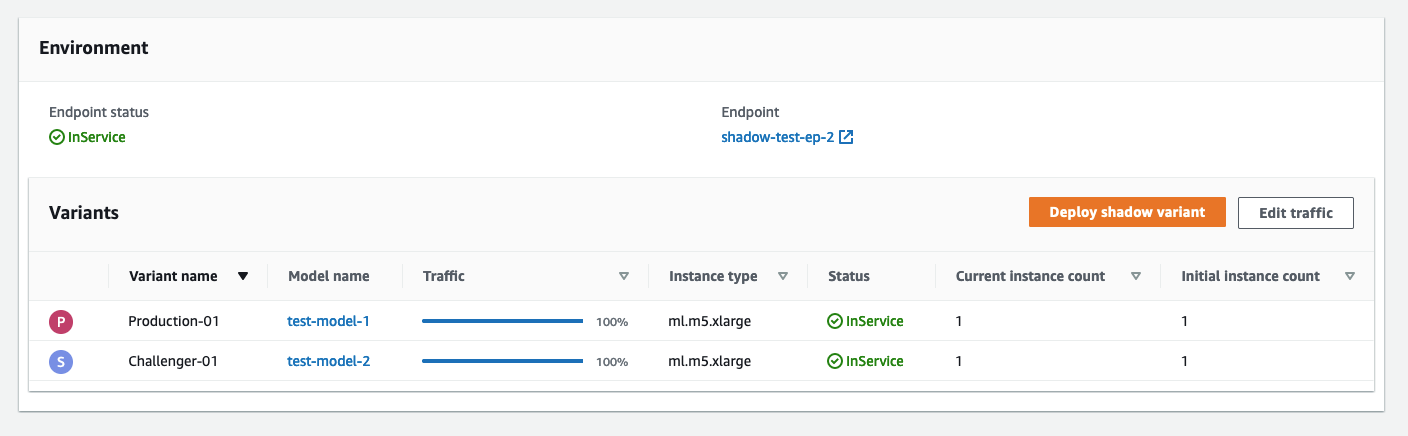

- Environnement

-

Cette section présente les variantes que vous avez comparées lors de l’essai. Si vous êtes satisfait des performances de la variante shadow, sur la base des métriques susmentionnées, vous pouvez promouvoir la variante shadow en production en choisissant Déployer la variante shadow. Pour plus de détails sur le déploiement d’une variante shadow, consultez Promotion d’une variante shadow. Vous pouvez également modifier le pourcentage d’échantillonnage du trafic et poursuivre les essais en choisissant Modifier le trafic. Pour plus de détails sur la modification d’une variante shadow, consultez Modifier un essai miroir. La capture d’écran suivante montre cette section.