Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Utilizzo dell'Upgrade Agent

Modalità di distribuzione supportate

Apache Spark Upgrade Agent per Amazon EMR supporta le seguenti due modalità di distribuzione per l'esperienza di aggiornamento delle applicazioni end-to-end Spark, tra cui aggiornamento del file di build, script/dependency aggiornamento, test e convalida locali con cluster EMR di destinazione o applicazione EMR Serverless e convalida della qualità dei dati.

-

EMR attivo EC2

-

EMR Serverless

Si prega di fare riferimento Caratteristiche e funzionalità a per comprendere le caratteristiche, le capacità e le limitazioni dettagliate.

Interfacce supportate

Integrazione con Amazon SageMaker Unified Studio VS Code Editor Spaces

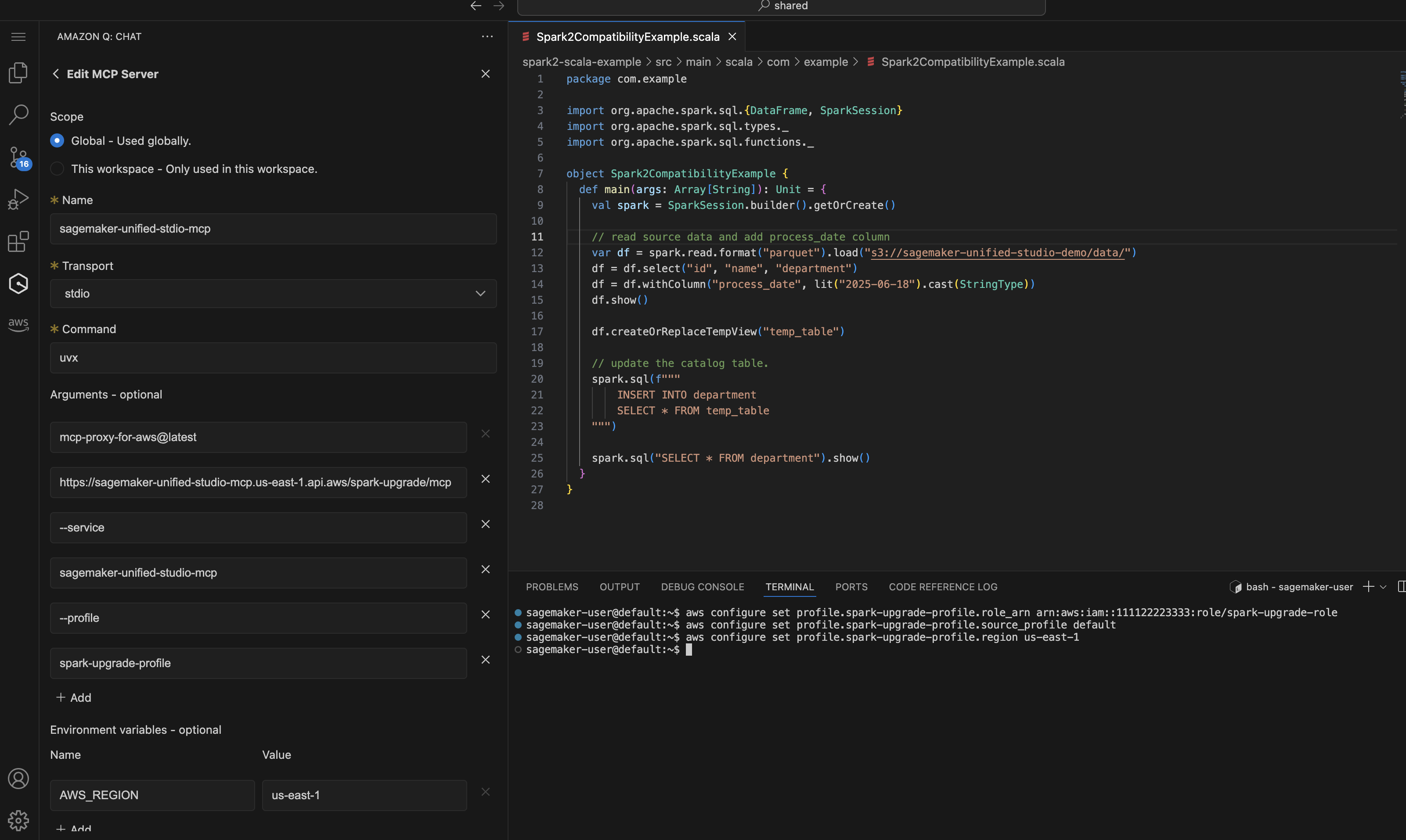

Su Amazon SageMaker Unified Studio VS Code Editor Spaces, puoi configurare il profilo IAM e la configurazione MCP come descritto nel Setup for Upgrade Agent semplicemente seguendo la schermata seguente:

Una dimostrazione dell'esperienza di aggiornamento EMR con l' EC2 editor di codice SMUS VS. Inizia con un semplice prompt per chiedere all'agente di avviare il processo di aggiornamento di Spark.

Upgrade my Spark application <local-project-path> from EMR version 6.0.0 to 7.12.0. Use EMR-EC2 Cluster <cluster-id> to run the validation and s3 paths s3://<please fill in your staging bucket path> to store updated application artifacts. Use spark-upgrade-profile for AWS CLI operations.

Integrazione con Kiro CLI (QCLI)

Avvia Kiro CLI o il tuo AI Assistant e verifica gli strumenti caricati per l'agente di aggiornamento.

... spark-upgrade (MCP): - check_and_update_build_environment * not trusted - check_and_update_python_environment * not trusted - check_job_status * not trusted - compile_and_build_project * not trusted ...

Una dimostrazione dell'esperienza di aggiornamento EMR Serverless con Kiro CLI. Puoi semplicemente avviare il processo di aggiornamento con la seguente richiesta:

Upgrade my Spark application <local-project-path> from EMR version 6.0.0 to 7.12.0. Use EMR-Serverless Applicaion <application-id> and execution role <your EMR Serverless job execution role> to run the validation and s3 paths s3://<please fill in your staging bucket path> to store updated application artifacts.

Integrazione con Altro IDEs

La configurazione può essere utilizzata anche in altri modi IDEs per connettersi al server Managed MCP:

-

Integrazione con Cline: per utilizzare il server MCP con Cline, modifica

cline_mcp_settings.jsone aggiungi la configurazione precedente. Consultate la documentazione di Clineper ulteriori informazioni su come gestire la configurazione MCP. -

Integrazione con Claude Code Per utilizzare il server MCP con Claude Code, modifica il file di configurazione per includere la configurazione MCP. Il percorso del file varia a seconda del sistema operativo. Per una configurazione dettagliata, fare riferimento a https://code.claude.com/docs/en/mcp

. -

Integrazione con GitHub Copilot - Per utilizzare il server MCP con GitHub Copilot, segui le istruzioni contenute in https://docs.github.com/en/copilot/how-tos/provide-context/use-mcp/extend- copilot-chat-with-mcp

per modificare il file di configurazione corrispondente e segui le istruzioni di ciascun IDE per attivare la configurazione.

Configurazione del cluster EMR o dell'applicazione serverless EMR per la versione di destinazione

Crea il cluster EMR o l'applicazione EMR Serverless con la versione Spark prevista che intendi utilizzare per l'applicazione aggiornata. Il cluster EMR o l'applicazione EMR-S di destinazione verranno utilizzati per inviare i job di convalida eseguiti dopo l'aggiornamento degli artefatti dell'applicazione Spark per verificare l'avvenuto aggiornamento o correggere gli errori aggiuntivi riscontrati durante la convalida. Se disponi già di un cluster EMR di destinazione o di un'applicazione EMR Serverless, puoi fare riferimento a quello esistente e saltare questo passaggio. Usare account di sviluppo non di produzione e selezionare esempi di set di dati fittizi che rappresentino i dati di produzione ma di dimensioni più piccole per la convalida con Spark Upgrades. Fare riferimento a questa pagina per le indicazioni su come creare un cluster EMR di destinazione o un'applicazione EMR Serverless da quelli esistenti:. Creazione di un cluster EMR di destinazione/applicazione EMR-S da quelli esistenti