Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Implementazione di modelli per l’inferenza in tempo reale

Importante

Le policy IAM personalizzate che consentono ad Amazon SageMaker Studio o Amazon SageMaker Studio Classic di creare risorse Amazon SageMaker devono inoltre concedere le autorizzazioni per aggiungere tag a tali risorse. L’autorizzazione per aggiungere tag alle risorse è necessaria perché Studio e Studio Classic applicano automaticamente tag a tutte le risorse che creano. Se una policy IAM consente a Studio e Studio Classic di creare risorse ma non consente il tagging, possono verificarsi errori di tipo “AccessDenied” quando provi a creare le risorse. Per ulteriori informazioni, consulta Fornisci le autorizzazioni per etichettare SageMaker le risorse AI.

AWSpolitiche gestite per Amazon SageMaker AI che forniscono autorizzazioni per creare risorse SageMaker includono già le autorizzazioni per aggiungere tag durante la creazione di tali risorse.

Esistono diverse opzioni per implementare un modello utilizzando i servizi di hosting SageMaker AI. È possibile implementare un modello in modo interattivo con SageMaker Studio. In alternativa, è possibile implementare un modello a livello di codice utilizzando un AWS SDK come SageMaker Python SDK o SDK per Python (Boto3). È inoltre possibile eseguire l’implementazione mediante l’AWS CLI.

Prima di iniziare

Prima di implementare un modello SageMaker AI, individua e prendi nota di quanto segue:

-

La Regione AWS in cui si trova il bucket Amazon S3

-

Il percorso URI Amazon S3 in cui sono archiviati gli artefatti del modello

-

Il ruolo IAM per SageMaker AI

-

Il percorso del registro URI Amazon ECR di Docker per l’immagine personalizzata che contiene il codice di inferenza o il framework e la versione di un’immagine Docker integrata supportata da AWS

Per un elenco dei Servizi AWS disponibili in ogni Regione AWS, consulta Region Maps and Edge Networks

Importante

Il bucket Amazon S3 in cui sono archiviati gli artefatti del modello devono trovarsi nella stessa Regione AWS del modello che si sta creando.

Utilizzo condiviso delle risorse con più modelli

È possibile implementare uno o più modelli in un endpoint con Amazon SageMaker AI. Quando più modelli condividono un endpoint, utilizzano congiuntamente le risorse ospitate al suo interno, come le istanze di calcolo ML, le CPU e gli acceleratori. Il modo più flessibile per implementare più modelli su un endpoint consiste nel definire ogni modello come componente di inferenza.

Componenti di inferenza

Un componente di inferenza è un oggetto di hosting SageMaker AI che è possibile utilizzare per implementare un modello in un endpoint. Nelle impostazioni del componente di inferenza vengono specificati il modello, l’endpoint e il modo in cui il modello utilizza le risorse ospitate dall’endpoint. Per specificare il modello, è possibile specificare un oggetto del modello SageMaker AI oppure direttamente gli artefatti e l’immagine del modello.

Nelle impostazioni è possibile ottimizzare l’utilizzo delle risorse personalizzando il modo in cui i core della CPU, gli acceleratori e la memoria richiesti vengono allocati al modello. È possibile implementare più componenti di inferenza in un endpoint, in cui ogni componente di inferenza contiene un modello e le relative esigenze di utilizzo delle risorse.

Dopo aver implementato un componente di inferenza, è possibile invocare direttamente il modello associato quando tramite l’azione InvokeEndpoint nell’API SageMaker.

I componenti di inferenza offrono i seguenti vantaggi:

- Flessibilità

-

Il componente di inferenza disaccoppia i dettagli dell’hosting del modello dall’endpoint stesso. Ciò offre livelli superiori di flessibilità e controllo sul modo in cui i modelli vengono ospitati e serviti con un endpoint. È possibile ospitare più modelli sulla stessa infrastruttura e aggiungere o rimuovere modelli da un endpoint in base alle esigenze. È possibile aggiornare ogni modello in modo indipendente.

- Scalabilità

-

È possibile specificare il numero di copie di ciascun modello da ospitare e impostare un numero minimo di copie per garantire che il modello venga caricato nella quantità necessaria per soddisfare le richieste. È possibile scalare qualsiasi copia di un componente di inferenza fino a zero, lasciando spazio a un’altra copia da aumentare verticalmente.

SageMaker AI crea un pacchetto dei modelli come componenti di inferenza quando vengono implementati utilizzando:

-

SageMaker Studio Classic;

-

SageMaker Python SDK per implementare un oggetto di modello (impostando il tipo di endpoint su

EndpointType.INFERENCE_COMPONENT_BASED); -

AWS SDK per Python (Boto3) per definire oggetti

InferenceComponentda implementare in un endpoint.

Implementare modelli con SageMaker Studio

Completa la seguente procedura per creare e implementare il modello in modo interattivo tramite SageMaker Studio. Per ulteriori informazioni, consulta la documentazione di Studio. Per ulteriori informazioni dettagliate sui vari scenari di implementazione, consulta il blog Package and deploy classical ML models and LLMs easily with Amazon SageMaker AI - Part 2

Preparare gli artefatti e le autorizzazioni

Completa questa sezione prima di creare un modello in SageMaker Studio.

Hai due opzioni per utilizzare artefatti personalizzati e creare un modello in Studio:

-

Puoi utilizzare un archivio

tar.gzpersonale preconfezionato, che deve includere gli artefatti del modello, eventuale codice di inferenza personalizzato e tutte le dipendenze elencate in un filerequirements.txt. -

SageMaker AI può creare automaticamente un pacchetto degli artefatti. È sufficiente includere gli artefatti del modello non elaborati ed eventuali dipendenze in un file

requirements.txt: SageMaker AI può fornire il codice di inferenza predefinito (oppure è possibile sostituire il codice predefinito con un codice di inferenza personalizzato). SageMaker AI supporta questa opzione per i seguenti framework: PyTorch, XGBoost.

Oltre a utilizzare il modello personalizzato, il ruolo AWS Identity and Access Management (IAM) e un container Docker (o il framework e la versione desiderati per i quali SageMaker AI dispone di un container predefinito), è anche necessario concedere le autorizzazioni per creare e implementare modelli tramite SageMaker AI Studio.

Le policy AmazonSageMakerFullAccess deve essere collegata al ruolo IAM in modo da poter accedere a SageMaker AI e altri servizi pertinenti. Per visualizzare i prezzi dei tipi di istanze in Studio, è anche necessario collegare la policy AWSPriceListServiceFullAccess (o, anziché l’intera policy, più specificamente, solo l’azione pricing:GetProducts).

Per caricare gli artefatti del modello durante la creazione di un modello (o caricare un file di payload di esempio per i consigli di inferenza), è necessario creare un bucket Amazon S3. Il nome del bucket deve essere preceduto dalla parola SageMaker AI. Sono accettabili anche altre combinazioni di maiuscole e minuscole di SageMaker AI: Sagemaker oppure sagemaker.

È consigliabile utilizzare la convenzione di denominazione dei bucket sagemaker-{. Questo bucket viene utilizzato per archiviare gli artefatti caricati.Region}-{accountID}

Dopo aver creato il bucket, collega la seguente policy CORS (Cross-Origin Resource Sharing) al bucket:

[ { "AllowedHeaders": ["*"], "ExposeHeaders": ["Etag"], "AllowedMethods": ["PUT", "POST"], "AllowedOrigins": ['https://*.sagemaker.aws'], } ]

Puoi collegare una policy CORS a un bucket Amazon S3 utilizzando uno dei seguenti metodi:

-

tramite la pagina Modifica la condivisione delle risorse multiorigine (CORS)

nella console di Amazon S3; -

utilizzando PutBucketCors nell’API Amazon S3;

-

Utilizzando il comando put-bucket-cors dell’AWS CLI:

aws s3api put-bucket-cors --bucket="..." --cors-configuration="..."

Creare un modello implementabile

In questa fase è possibile creare una versione implementabile del modello in SageMaker AI fornendo gli artefatti insieme a specifiche aggiuntive, come il container e il framework desiderati, eventuale codice di inferenza personalizzato e le impostazioni di rete.

Per creare un modello implementabile in SageMaker Studio, segui questa procedura:

-

Apri l’applicazione SageMaker Studio.

-

Nel riquadro di navigazione a sinistra scegliere Models (Modelli).

-

Scegli la scheda Modelli implementabili.

-

Nella pagina Modelli implementabili, scegli Crea.

-

Nella pagina Crea modello implementabile, nel campo Nome modello, inserisci un nome per il modello.

Sono presenti altre sezioni da compilare nella pagina Crea modello implementabile.

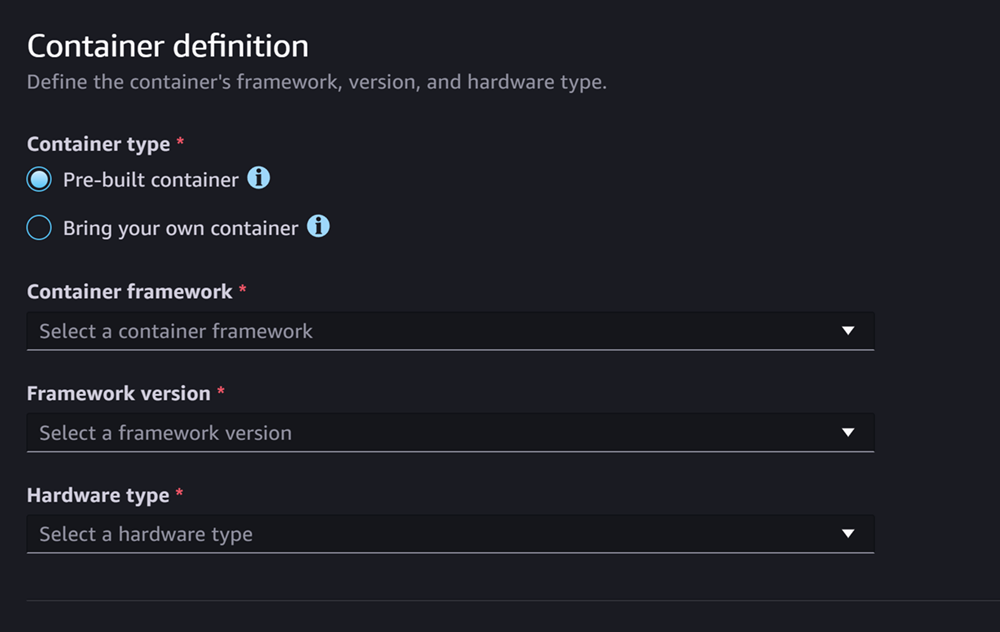

La sezione Definizione di container ha l’aspetto del seguente screenshot:

Per la sezione Definizione di container segui questa procedura:

-

Per Tipo di container, seleziona Container predefinito se desideri utilizzare un container gestito da SageMaker AI oppure seleziona Porta il tuo container per utilizzare un container personale.

-

Se hai selezionato Container predefinito, seleziona i valori di Framework del container, Versione del framework e Tipo di hardware che desideri utilizzare.

-

Se hai selezionato Porta il tuo container, inserisci un percorso Amazon ECR per Percorso ECR a immagine container.

Quindi, compila la sezione Artefatti, simile al seguente screenshot:

Per la sezione Artefatti segui questa procedura:

-

Se utilizzi uno dei framework supportati da SageMaker AI per la creazione di pacchetti degli artefatti del modello (PyTorch o XGBoost), per Artefatti puoi scegliere l’opzione Carica artefatti. Con questa opzione, puoi semplicemente specificare gli artefatti del modello non elaborati, eventuale codice di inferenza personalizzato e il file requirements.txt; SageMaker AI gestisce la creazione automatica del pacchetto dell’archivio. Esegui questa operazione:

-

Per Artefatti, seleziona Carica artefatti per continuare a fornire i file. Altrimenti, se disponi già di un archivio

tar.gzche contiene i file del modello, il codice di inferenza e il filerequirements.txt, seleziona Inserisci URI S3 per pacchetti di artefatti. -

Se hai scelto di caricare i tuoi artefatti, per Bucket S3, inserisci il percorso Amazon S3 di un bucket in cui SageMaker AI deve archiviare gli artefatti dopo averli inseriti in un pacchetto. Quindi, completa questa procedura.

-

Per Carica artefatti modello, carica i file del modello.

-

Per Codice di inferenza, seleziona Usa codice di inferenza predefinito per utilizzare il codice predefinito fornito da SageMaker AI per l’inferenza. Altrimenti, seleziona Carica codice di inferenza personalizzato per utilizzare un codice di inferenza personalizzato.

-

Per Carica requirements.txt, carica un file di testo che elenchi tutte le dipendenze da installare in fase di esecuzione.

-

-

Se non utilizzi un framework supportato da SageMaker AI per la creazione di pacchetti degli artefatti del modello, Studio mostra l’opzione Pacchetti di artefatti e devi fornire tutti gli artefatti già inseriti in un pacchetto come archivio

tar.gz. Esegui questa operazione:-

Per Pacchetti di artefatti, seleziona Inserisci URI S3 per pacchetti di artefatti del modello se l’archivio

tar.gzè già stato caricato in Amazon S3. Seleziona Carica pacchetti di artefatti del modello per caricare direttamente l’archivio su SageMaker AI. -

Se hai selezionato Inserisci URI S3 per pacchetti di artefatti del modello, inserisci il percorso Amazon S3 dell’archivio per l’URI S3. Altrimenti, seleziona e carica l’archivio dal tuo computer locale.

-

La sezione successiva è Sicurezza, simile allo screenshot seguente:

Per la sezione Sicurezza, segui questa procedura:

-

Per Ruolo IAM, inserisci l’ARN per un ruolo IAM.

-

(Facoltativo) Per Cloud privato virtuale (VPC), puoi selezionare un Amazon VPC per archiviare la configurazione e gli artefatti del modello.

-

(Facoltativo) Attiva l’interruttore Isolamento di rete per limitare l’accesso a Internet del container.

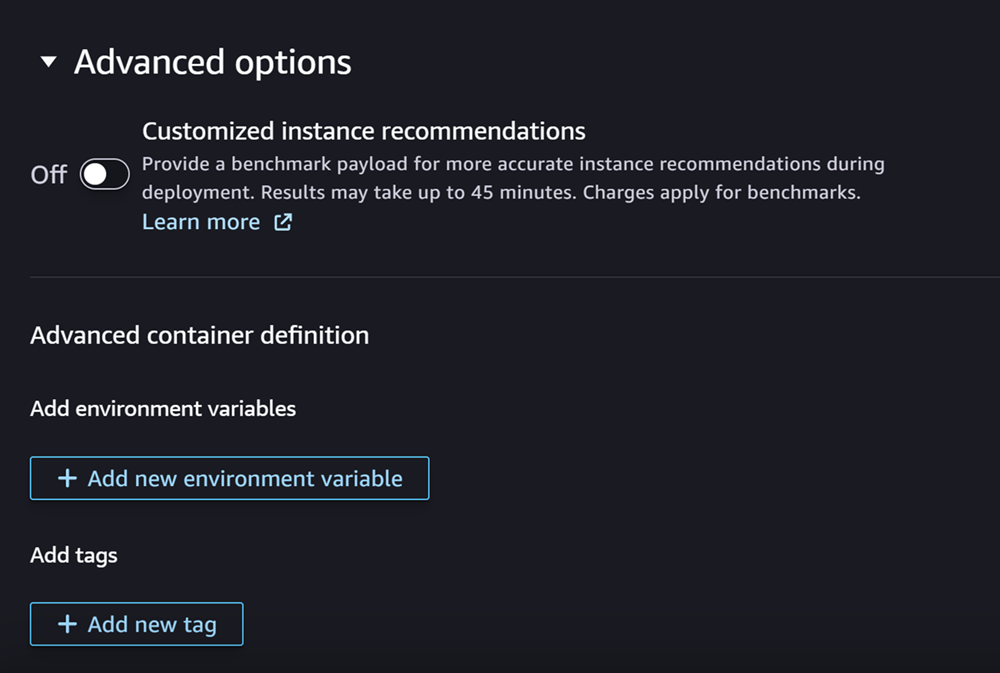

Infine, è possibile facoltativamente compilare la sezione Opzioni avanzate, simile al seguente screenshot:

(Facoltativo) Per la sezione Opzioni avanzate segui questa procedura:

-

Attiva l’interruttore Consigli per istanze personalizzate per eseguire un processo Amazon SageMaker Inference Recommender nel modello dopo la creazione. Inference Recommender è una funzionalità che fornisce tipi di istanze consigliati per ottimizzare le prestazioni e i costi dell’inferenza. È possibile visualizzare questi consigli sulle istanze durante la preparazione all’implementazione del modello.

-

Per Aggiungi variabili di ambiente, inserisci una variabile di ambiente per il container come coppie chiave-valore.

-

Per Tag, inserisci i tag come coppie chiave-valore.

-

Dopo aver completato la configurazione del modello e del container, scegli Crea modello implementabile.

Ora dovresti avere un modello in SageMaker Studio pronto per l’implementazione.

Distribuzione del modello

Infine, è possibile implementare il modello configurato nella fase precedente in un endpoint HTTPS. È possibile implementare un singolo modello o più modelli sull’endpoint.

Compatibilità tra modelli ed endpoint

Prima di poter implementare un modello in un endpoint, è necessario che il modello e l’endpoint siano compatibili e abbiano gli stessi valori per le seguenti impostazioni:

-

Ruolo IAM

-

Amazon VPC, comprese le sottoreti e i gruppi di sicurezza

-

Isolamento di rete (abilitato o disabilitato)

Studio impedisce di implementare modelli in endpoint incompatibili nei seguenti modi:

-

Se tenti di implementare un modello in un nuovo endpoint, SageMaker AI configura l’endpoint con impostazioni iniziali compatibili. Se interrompi la compatibilità modificando queste impostazioni, Studio mostra un avviso e impedisce l’implementazione.

-

Se tenti di eseguire l’implementazione in un endpoint esistente e tale endpoint è incompatibile, Studio mostra un avviso e impedisce l’implementazione.

-

Se si tenta di aggiungere più modelli a un’implementazione, Studio impedisce di implementare i modelli incompatibili tra loro.

Quando Studio mostra l’avviso sull’incompatibilità tra modello ed endpoint, è possibile scegliere Visualizza dettagli nell’avviso per vedere quali impostazioni sono incompatibili.

Un modo per implementare un modello consiste nel seguire questa procedura in Studio:

-

Apri l’applicazione SageMaker Studio.

-

Nel riquadro di navigazione a sinistra scegliere Models (Modelli).

-

Nella pagina Modelli, seleziona uno o più modelli dall’elenco dei modelli di SageMaker AI.

-

Seleziona Deploy (Implementa).

-

Per Nome endpoint, apri il menu a discesa. È possibile selezionare un endpoint esistente oppure creare un nuovo endpoint in cui implementare il modello.

-

Per Tipo di istanza, seleziona il tipo di istanza da utilizzare per l’endpoint. Se in precedenza hai eseguito un processo Inference Recommender per il modello, i tipi di istanza consigliati vengono visualizzati nell’elenco sotto il titolo Consigliato. Altrimenti, vedrai alcune istanze potenziali che potrebbero essere adatte al tuo modello.

Compatibilità con il tipo di istanza per JumpStart

Se stai implementando un modello JumpStart, Studio mostra solo i tipi di istanza supportati dal modello.

-

Per Conteggio istanze iniziale, inserisci il numero iniziale di istanze che desideri fornire per il tuo endpoint.

-

Per Numero massimo di istanze, specifica il numero massimo di istanze che l’endpoint può fornire in caso di aumento verticale per far fronte a un incremento di traffico.

-

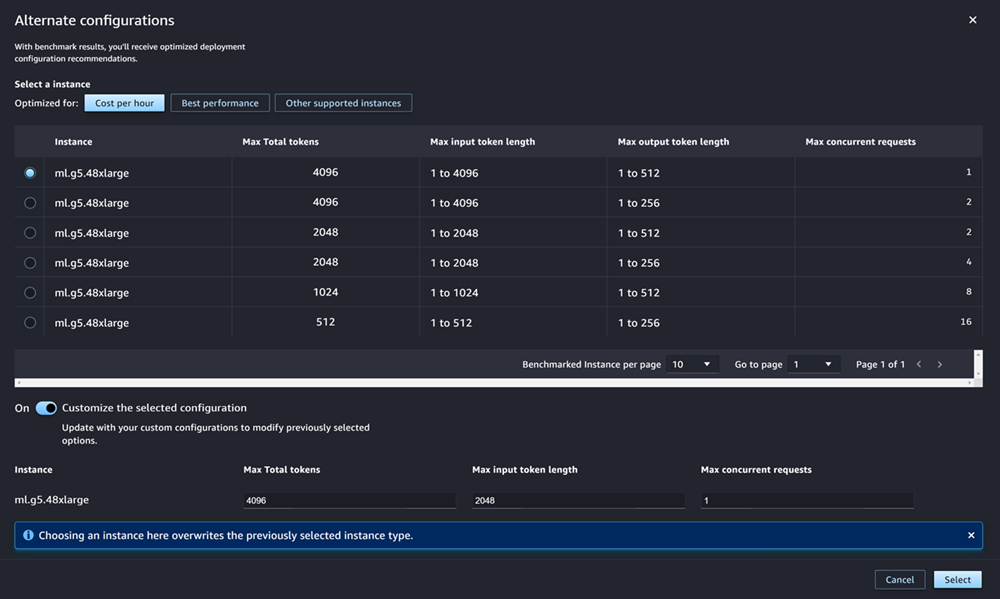

Se il modello che stai implementando è uno degli LLM JumpStart più utilizzati dall’hub del modello, l’opzione Configurazioni alternative viene visualizzata dopo i campi del tipo di istanza e del numero di istanze.

Per gli LLM JumpStart più diffusi, AWS dispone di pacchetti predefiniti di tipi di istanze per ottimizzare i costi o le prestazioni. Questi dati possono aiutarti a decidere quale tipo di istanza utilizzare per implementare il tuo LLM. Scegli Configurazioni alternative per aprire una finestra di dialogo che contiene i dati prevalutati. Il pannello ha un aspetto simile al seguente screenshot:

Nella casella Configurazioni alternative, segui questa procedura:

-

Selezione di un tipo di istanza. Puoi scegliere Costo all’ora o Prestazioni ottimali per visualizzare i tipi di istanze che ottimizzano i costi o le prestazioni per il modello specificato. Puoi anche scegliere Altre istanze supportate per visualizzare un elenco di altri tipi di istanze compatibili con il modello JumpStart. La selezione di un tipo di istanza qui sovrascrive qualsiasi selezione di istanza precedente specificata nella fase 6.

-

(Facoltativo) Attiva l’interruttore Personalizza la configurazione selezionata per specificare i valori di Numero massimo di token totali (il numero massimo di token che desideri consentire, ovvero la somma dei token di input e dell’output generato dal modello), Lunghezza massima di token per input (il numero massimo di token che desideri consentire per l’input di ogni richiesta) e Numero massimo di richieste simultanee (il numero massimo di richieste che il modello può elaborare simultaneamente).

-

Scegli Seleziona per confermare il tipo di istanza e le impostazioni di configurazione.

-

-

Il campo Modello dovrebbe già essere compilato con il nome del modello o dei modelli che stai implementando. Puoi scegliere Aggiungi modello per aggiungere altri modelli all’implementazione. Per ogni modello aggiunto, compila i seguenti campi:

-

Per Numero di core CPU, inserisci i core CPU che desideri dedicare all’utilizzo del modello.

-

Per Numero minimo di copie, inserisci il numero minimo di copie del modello che desideri ospitare sull’endpoint in un dato momento.

-

Per Memoria CPU minima (MB), inserisci la quantità minima di memoria (in MB) richiesta dal modello.

-

Per Memoria CPU massima (MB), inserisci la quantità massima di memoria (in MB) che desideri consentire al modello di utilizzare.

-

-

(Facoltativo) Per Opzioni avanzate, segui questa procedura:

-

Per Ruolo IAM, utilizza il ruolo di esecuzione IAM predefinito di SageMaker AI o specifica un ruolo personalizzato con le autorizzazioni necessarie. Questo ruolo IAM deve essere lo stesso del ruolo specificato durante la creazione del modello implementabile.

-

Per Cloud privato virtuale (VPC), puoi specificare un VPC in cui ospitare l’endpoint.

-

Per Chiave KMS di crittografia, seleziona una chiave AWS KMS per crittografare i dati nel volume di archiviazione collegato all’istanza di calcolo ML che ospita l’endpoint.

-

Attiva l’interruttore Abilita l’isolamento di rete per limitare l’accesso a Internet del container.

-

Per la Configurazione del timeout, inserisci i valori per i campi Timeout per il download dei dati del modello (secondi) e Timeout per il controllo dell’integrità di avvio del container (secondi). Questi valori determinano il tempo massimo consentito da SageMaker AI rispettivamente per scaricare il modello nel container e avviare il container.

-

Per Tag, inserisci i tag come coppie chiave-valore.

Nota

SageMaker AI configura il ruolo IAM, VPC e le impostazioni di isolamento della rete con valori iniziali compatibili con il modello che stai implementando. Se interrompi la compatibilità modificando queste impostazioni, Studio mostra un avviso e impedisce l’implementazione.

-

Dopo aver configurato le opzioni, la pagina sarà simile allo screenshot seguente.

Dopo aver configurato l’implementazione, scegli Implementa per creare l’endpoint e implementare il modello.

Implementare modelli con gli SDK Python

Utilizzando SageMaker Python SDK è possibile creare un modello in due modi. Il primo consiste nel creare un oggetto di modello dalla classe Model oppure ModelBuilder. In caso di utilizzo della classe Model per creare un oggetto Model, è necessario specificare il pacchetto del modello o il codice di inferenza (a seconda del server del modello), gli script per gestire la serializzazione e la deserializzazione dei dati tra il client e il server ed eventuali dipendenze da caricare su Amazon S3 per il consumo. Il secondo modo per creare il modello consiste nell’utilizzare ModelBuilder per cui fornire artefatti del modello o codice di inferenza. ModelBuilder acquisisce automaticamente le dipendenze, deduce le funzioni di serializzazione e deserializzazione necessarie e genera un pacchetto delle dipendenze per creare l’oggetto Model. Per ulteriori informazioni su ModelBuilder, consulta Creare un modello in Amazon SageMaker AI con ModelBuilder.

La sezione seguente descrive entrambi i metodi per creare il modello e implementare l’oggetto di modello.

Configurazione

Gli esempi seguenti preparano il processo di implementazione del modello. Importano le librerie necessarie e definiscono l’URL S3 che individua gli artefatti del modello.

Esempio URL degli artefatti del modello

Il codice seguente crea un esempio di URL Amazon S3. L’URL individua gli artefatti di un modello preaddestrato in un bucket Amazon S3.

# Create a variable w/ the model S3 URL # The name of your S3 bucket: s3_bucket = "amzn-s3-demo-bucket" # The directory within your S3 bucket your model is stored in: bucket_prefix = "sagemaker/model/path" # The file name of your model artifact: model_filename = "my-model-artifact.tar.gz" # Relative S3 path: model_s3_key = f"{bucket_prefix}/"+model_filename # Combine bucket name, model file name, and relate S3 path to create S3 model URL: model_url = f"s3://{s3_bucket}/{model_s3_key}"

L’URL Amazon S3 completo è archiviato nella variabile model_url, utilizzata negli esempi seguenti.

Panoramica

Esistono diversi modi per implementare modelli con SageMaker Python SDK o SDK per Python (Boto3). Le sezioni seguenti riepilogano le fasi da completare per diversi approcci possibili. Queste fasi sono illustrate negli esempi che seguono.

Configura

Gli esempi seguenti configurano le risorse necessarie per implementare un modello in un endpoint.

Implementazione

Gli esempi seguenti implementano un modello in un endpoint.

Implementare modelli con l’AWS CLI

È possibile implementare un modello in un endpoint utilizzando l’AWS CLI.

Panoramica

Quando si implementa un modello con l’AWS CLI, è possibile implementarlo utilizzando o meno un componente di inferenza. Le sezioni seguenti riepilogano i comandi da eseguire per entrambi gli approcci. Questi comandi sono illustrati negli esempi che seguono.

Configura

Gli esempi seguenti configurano le risorse necessarie per implementare un modello in un endpoint.

Implementazione

Gli esempi seguenti implementano un modello in un endpoint.