Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Script del ciclo di vita di base forniti da HyperPod

Questa sezione illustra ogni componente del flusso di base di configurazione di Slurm on HyperPod con un approccio dall'alto verso il basso. Inizia dalla preparazione di una richiesta di creazione HyperPod del cluster per eseguire l'CreateClusterAPI e approfondisce la struttura gerarchica fino agli script del ciclo di vita. Utilizza gli script di esempio relativi al ciclo di vita forniti nell'archivio Awsome Distributed Training. GitHub

git clone https://github.com/aws-samples/awsome-distributed-training/

Gli script del ciclo di vita di base per la configurazione di un cluster Slurm sono disponibili all'indirizzo. SageMaker HyperPod 1.architectures/5.sagemaker_hyperpods/LifecycleScripts/base-config

cd awsome-distributed-training/1.architectures/5.sagemaker_hyperpods/LifecycleScripts/base-config

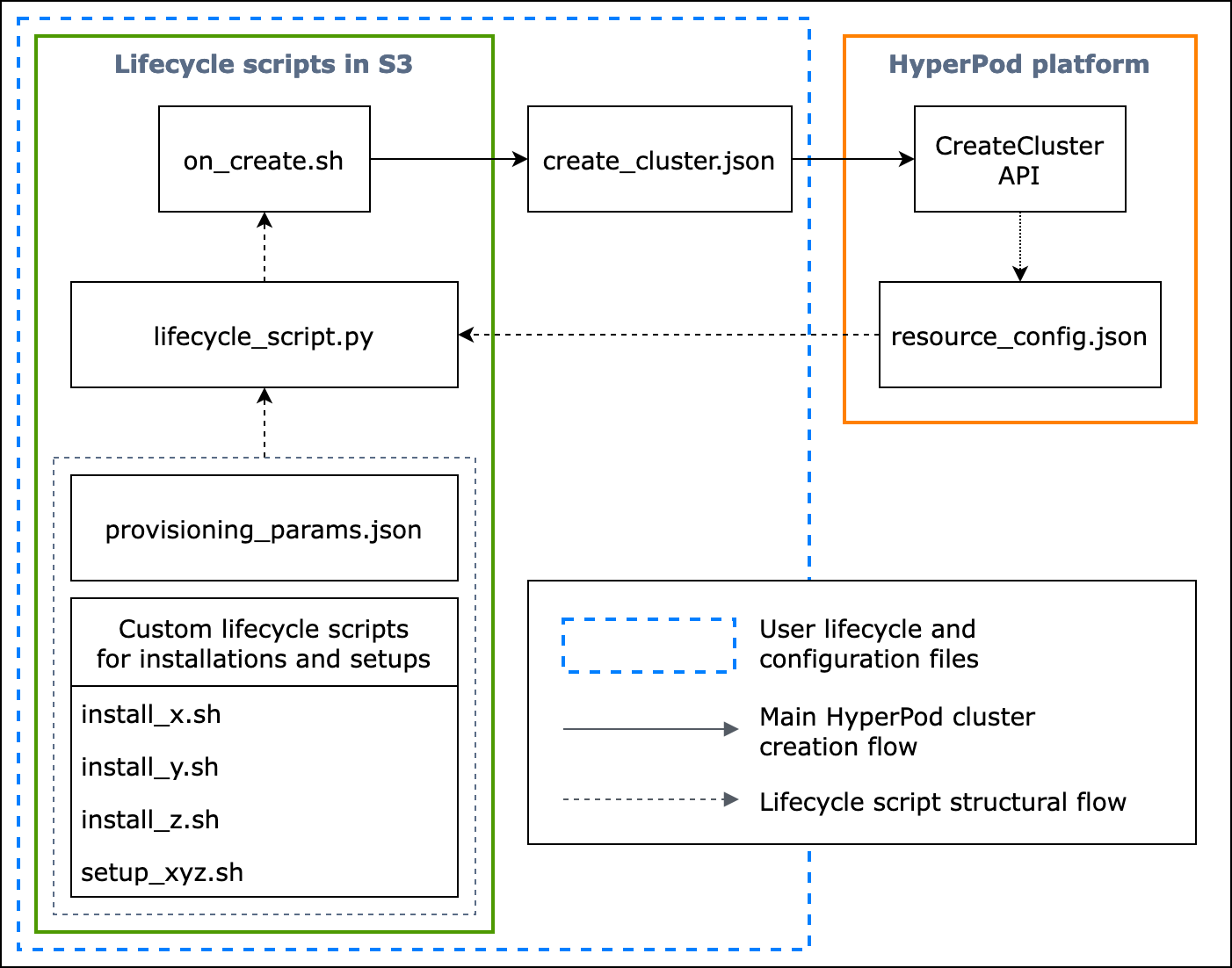

Il diagramma di flusso seguente mostra una panoramica dettagliata di come progettare gli script del ciclo di vita di base. Le descrizioni sotto il diagramma e la guida procedurale spiegano come funzionano durante la chiamata API. HyperPod CreateCluster

Figura: Un diagramma di flusso dettagliato della creazione dei HyperPod cluster e della struttura degli script del ciclo di vita. (1) Le frecce tratteggiate indicano il punto in cui vengono “richiamate” le caselle e mostrano il flusso dei file di configurazione e la preparazione degli script del ciclo di vita. Il processo inizia dalla preparazione del file provisioning_parameters.json e degli script del ciclo di vita. Questi vengono quindi codificati in lifecycle_script.py per essere eseguiti in ordine collettivamente. E l'esecuzione dello lifecycle_script.py script viene eseguita dallo script di on_create.sh shell, che deve essere eseguito nel terminale dell' HyperPodistanza. (2) Le frecce piene mostrano il flusso principale di creazione del HyperPod cluster e il modo in cui le caselle vengono «richiamate» o «inviate a». on_create.shè necessario per la richiesta di creazione del cluster, nel modulo Crea una richiesta di cluster create_cluster.json o nel modulo Crea una richiesta di cluster nell'interfaccia utente della console. Dopo aver inviato la richiesta, HyperPod esegue l'CreateClusterAPI in base alle informazioni di configurazione fornite dalla richiesta e dagli script del ciclo di vita. (3) La freccia punteggiata indica che la HyperPod piattaforma crea istanze resource_config.json nel cluster durante il provisioning delle risorse del cluster. resource_config.jsoncontiene informazioni sulle risorse del HyperPod cluster come l'ARN del cluster, i tipi di istanza e gli indirizzi IP. È importante notare che gli script del ciclo di vita vanno preparati in modo che prevedano il file resource_config.json durante la creazione del cluster. Per ulteriori informazioni, consulta la guida con le procedure di seguito.

La seguente guida procedurale spiega cosa succede durante la creazione del HyperPod cluster e come sono progettati gli script del ciclo di vita di base.

-

create_cluster.json— Per inviare una richiesta di creazione di un HyperPod cluster, si prepara un file diCreateClusterrichiesta in formato JSON. In questo esempio di best practice, supponiamo che il file di richiesta si chiamicreate_cluster.json. Scrivicreate_cluster.jsonper fornire gruppi di istanze a un HyperPod cluster. La best practice consiste nell'aggiungere lo stesso numero di gruppi di istanze del numero di nodi Slurm che intendi configurare sul HyperPod cluster. Assicurati di assegnare nomi distintivi ai gruppi di istanze che assegnerai ai nodi Slurm che intendi configurare.Inoltre, devi specificare un percorso al bucket S3 per archiviare l’intero set di file di configurazione e script del ciclo di vita nel campo

InstanceGroups.LifeCycleConfig.SourceS3Uridel modulo di richiestaCreateCluster. Inoltre, devi specificare il nome del file di uno script shell del punto di ingresso (chiamato, supponiamo,on_create.sh) inInstanceGroups.LifeCycleConfig.OnCreate.Nota

Se utilizzi il modulo di invio Crea un cluster nell'interfaccia utente della console, la HyperPod console gestisce la compilazione e l'invio della

CreateClusterrichiesta per tuo conto ed esegue l'CreateClusterAPI nel backend. In questo caso, non è necessario crearecreate_cluster.json, ma assicurati di specificare le informazioni corrette sulla configurazione del cluster nel modulo di invio Crea un cluster. -

on_create.sh— Per ogni gruppo di istanze, è necessario fornire uno script di shell entrypoint per eseguire comandion_create.sh, eseguire script per installare pacchetti software e configurare l'ambiente cluster con Slurm. HyperPod Le due cose da preparare sono unaprovisioning_parameters.jsonnecessaria per configurare Slurm e un set di script del ciclo di vita HyperPod per l'installazione dei pacchetti software. Questo script deve essere scritto per trovare ed eseguire i file seguenti, come mostrato nello script di esempio inon_create.sh. Nota

Assicurati di caricare l’intero set di script del ciclo di vita nella posizione S3 specificata in

create_cluster.json. Anche il fileprovisioning_parameters.jsondeve trovarsi nella stessa posizione.-

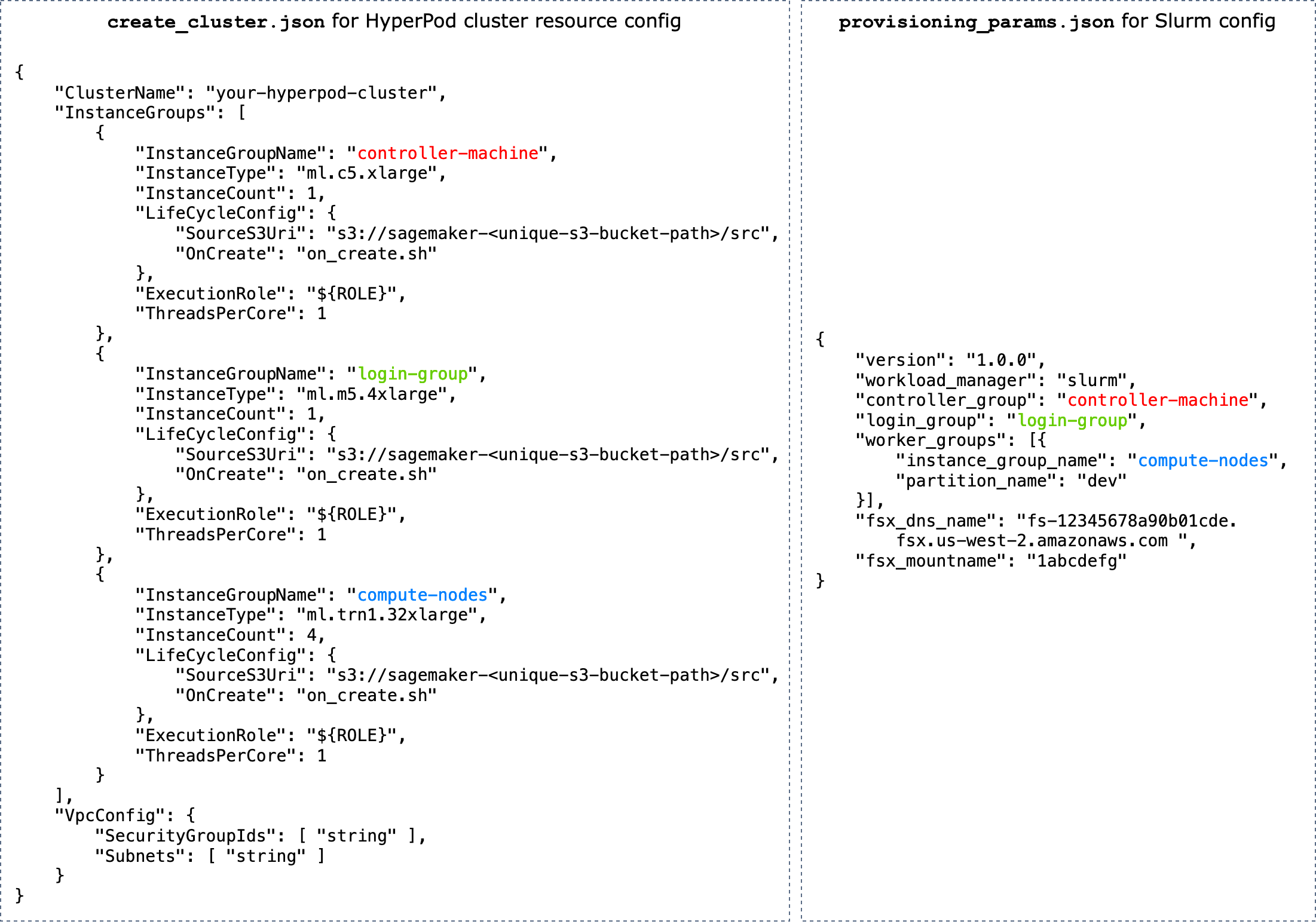

provisioning_parameters.json: questo è un Modulo di configurazione per il provisioning dei nodi Slurm su HyperPod. Lo scripton_create.shtrova questo file JSON e definisce la variabile di ambiente per identificarne il percorso. Tramite questo file JSON, puoi configurare nodi Slurm e opzioni di storage come Amazon FSx for Lustre for Slurm con cui comunicare. Inoltreprovisioning_parameters.json, assicurati di assegnare i gruppi di istanze del HyperPod cluster utilizzando i nomi specificati ai nodi Slurm in modo appropriato in basecreate_cluster.jsona come intendi configurarli.Il diagramma seguente mostra un esempio di come i due file di configurazione JSON

provisioning_parameters.jsondevono essere scritti per HyperPod assegnare i gruppi dicreate_cluster.jsonistanze ai nodi Slurm. In questo esempio, supponiamo di dover configurare tre nodi Slurm: il nodo controller (gestione), il nodo login (facoltativo) e il nodo di calcolo (worker).Suggerimento

Per aiutarti a convalidare questi due file JSON, il team di HyperPod assistenza fornisce uno script di convalida,.

validate-config.pyPer ulteriori informazioni, consulta Convalida dei file di configurazione JSON prima di creare un cluster Slurm su HyperPod.

Figura: Confronto diretto tra la configurazione per la creazione di HyperPod cluster e quella

create_cluster.jsonperprovisiong_params.jsonSlurm. Il numero di gruppi di istanze increate_cluster.jsondeve corrispondere al numero di nodi che intendi configurare come nodi Slurm. Nel caso dell'esempio in figura, tre nodi Slurm verranno configurati su un HyperPod cluster di tre gruppi di istanze. È necessario assegnare i gruppi di istanze del HyperPod cluster ai nodi Slurm specificando di conseguenza i nomi dei gruppi di istanze. -

resource_config.json— Durante la creazione del cluster, lolifecycle_script.pyscript viene scritto in modo da aspettarsi un file da.resource_config.jsonHyperPod Questo file contiene informazioni sul cluster, ad esempio i tipi di istanze e gli indirizzi IP.Quando esegui l'

CreateClusterAPI, HyperPod crea un file di configurazione delle risorse in/opt/ml/config/resource_config.jsonbase alcreate_cluster.jsonfile. Il percorso del file viene salvato nella variabile di ambiente denominataSAGEMAKER_RESOURCE_CONFIG_PATH.Importante

Il

resource_config.jsonfile viene generato automaticamente dalla HyperPod piattaforma e NON è necessario crearlo. Il codice seguente, che mostra un esempio del fileresource_config.jsongenerato dalla creazione del cluster in base al filecreate_cluster.jsondella fase precedente, ti aiuta a capire cosa succede nel backend e come è fatto un fileresource_config.jsongenerato automaticamente.{ "ClusterConfig": { "ClusterArn": "arn:aws:sagemaker:us-west-2:111122223333:cluster/abcde01234yz", "ClusterName": "your-hyperpod-cluster" }, "InstanceGroups": [ { "Name": "controller-machine", "InstanceType": "ml.c5.xlarge", "Instances": [ { "InstanceName": "controller-machine-1", "AgentIpAddress": "111.222.333.444", "CustomerIpAddress": "111.222.333.444", "InstanceId": "i-12345abcedfg67890" } ] }, { "Name": "login-group", "InstanceType": "ml.m5.xlarge", "Instances": [ { "InstanceName": "login-group-1", "AgentIpAddress": "111.222.333.444", "CustomerIpAddress": "111.222.333.444", "InstanceId": "i-12345abcedfg67890" } ] }, { "Name": "compute-nodes", "InstanceType": "ml.trn1.32xlarge", "Instances": [ { "InstanceName": "compute-nodes-1", "AgentIpAddress": "111.222.333.444", "CustomerIpAddress": "111.222.333.444", "InstanceId": "i-12345abcedfg67890" }, { "InstanceName": "compute-nodes-2", "AgentIpAddress": "111.222.333.444", "CustomerIpAddress": "111.222.333.444", "InstanceId": "i-12345abcedfg67890" }, { "InstanceName": "compute-nodes-3", "AgentIpAddress": "111.222.333.444", "CustomerIpAddress": "111.222.333.444", "InstanceId": "i-12345abcedfg67890" }, { "InstanceName": "compute-nodes-4", "AgentIpAddress": "111.222.333.444", "CustomerIpAddress": "111.222.333.444", "InstanceId": "i-12345abcedfg67890" } ] } ] } -

lifecycle_script.py— Questo è lo script Python principale che esegue collettivamente gli script del ciclo di vita impostando Slurm sul cluster durante il provisioning. HyperPod Questo script leggeprovisioning_parameters.jsoneresource_config.jsonnei percorsi specificati o identificati inon_create.sh, passa le informazioni pertinenti a ogni script del ciclo di vita e quindi esegue in ordine gli script del ciclo di vita.Gli script del ciclo di vita sono un set di script che offre la massima flessibilità di personalizzazione e consente di installare pacchetti software e impostare le configurazioni necessarie o personalizzate durante la creazione di cluster, ad esempio la configurazione di Slurm, la creazione di utenti e l’installazione di Conda o Docker.

lifecycle_script.pyLo script di esempio è pronto per eseguire altri script del ciclo di vita di base nel repository, come l'avvio di Slurm deamons () start_slurm.sh, il montaggio di Amazon FSx for Lustre () e la configurazione di MariaDB accounting () mount_fsx.she RDS accounting (). setup_mariadb_accounting.shsetup_rds_accounting.shPuoi anche aggiungere altri script, impacchettarli nella stessa directory e aggiungere righe di codice per consentire l'esecuzione degli script. lifecycle_script.pyHyperPod Per ulteriori informazioni sugli script del ciclo di vita di base, consulta anche gli script del ciclo di vita 3.1 nell'archivio Awsome Distributed Training. GitHub Nota

HyperPod viene eseguito SageMaker HyperPod DLAMI su ogni istanza di un cluster e l'AMI dispone di pacchetti software preinstallati che rispettano le compatibilità tra essi e le funzionalità. HyperPod Tieni presente che se reinstalli uno qualsiasi dei pacchetti preinstallati, sei responsabile dell'installazione dei pacchetti compatibili e tieni presente che alcune HyperPod funzionalità potrebbero non funzionare come previsto.

Oltre alle configurazioni predefinite, nella cartella

utilssono disponibili altri script per l’installazione dei software seguenti. Il file lifecycle_script.pyè già pronto per includere righe di codice per l’esecuzione degli script di installazione, quindi consulta le indicazioni seguenti per cercare tali righe e rimuovi i commenti per attivarle.-

Le righe di codice seguenti servono per l’installazione di Docker

, Enroot e Pyxis . Questi pacchetti sono necessari per eseguire i container Docker su un cluster Slurm. Per abilitare questa fase di installazione, imposta il parametro

enable_docker_enroot_pyxissuTruenel fileconfig.py. # Install Docker/Enroot/Pyxis if Config.enable_docker_enroot_pyxis: ExecuteBashScript("./utils/install_docker.sh").run() ExecuteBashScript("./utils/install_enroot_pyxis.sh").run(node_type) -

Puoi integrare il tuo HyperPod cluster con Amazon Managed Service for Prometheus e Amazon Managed Grafana per esportare i parametri relativi al cluster e ai nodi HyperPod del cluster nelle dashboard di Amazon Managed Grafana. Per esportare le metriche e utilizzare la dashboard Slurm

, la dashboard NVIDIA DCGM Exporter e la dashboard delle metriche EFA su Grafana gestito da Amazon, devi installare lo strumento di esportazione Slurm per Prometheus , lo strumento di esportazione NVIDIA DCGM e lo strumento di esportazione di nodi EFA . Per ulteriori informazioni sull’installazione dei pacchetti di esportazione e sull’utilizzo delle dashboard Grafana in uno spazio di lavoro Grafana gestito da Amazon, consulta SageMaker HyperPod monitoraggio delle risorse del cluster. Per abilitare questa fase di installazione, imposta il parametro

enable_observabilitysuTruenel fileconfig.py. # Install metric exporting software and Prometheus for observability if Config.enable_observability: if node_type == SlurmNodeType.COMPUTE_NODE: ExecuteBashScript("./utils/install_docker.sh").run() ExecuteBashScript("./utils/install_dcgm_exporter.sh").run() ExecuteBashScript("./utils/install_efa_node_exporter.sh").run() if node_type == SlurmNodeType.HEAD_NODE: wait_for_scontrol() ExecuteBashScript("./utils/install_docker.sh").run() ExecuteBashScript("./utils/install_slurm_exporter.sh").run() ExecuteBashScript("./utils/install_prometheus.sh").run()

-

-

-

Assicurati di caricare tutti i file e gli script di configurazione della Fase 2 nel bucket S3 fornito nella richiesta

CreateClusterdella Fase 1. Ad esempio, presupponi checreate_cluster.jsoncontenga quanto segue:"LifeCycleConfig": { "SourceS3URI": "s3://sagemaker-hyperpod-lifecycle/src", "OnCreate": "on_create.sh" }Di conseguenza,

"s3://sagemaker-hyperpod-lifecycle/src"dovrebbe contenereon_create.sh,lifecycle_script.py,provisioning_parameters.jsone tutti gli altri script di configurazione. Supponi di aver preparato i file in una cartella locale come segue.└── lifecycle_files // your local folder ├── provisioning_parameters.json ├── on_create.sh ├── lifecycle_script.py └── ... // more setup scrips to be fed into lifecycle_script.pyPer caricare i file, utilizza il comando S3 come segue.

aws s3 cp --recursive./lifecycle_scriptss3://sagemaker-hyperpod-lifecycle/src