Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Log e parametri della pipeline di inferenza

Il monitoraggio è importante per mantenere l'affidabilità, la disponibilità e le prestazioni delle risorse SageMaker AI di Amazon. Per monitorare e risolvere i problemi delle prestazioni della pipeline di inferenza, usa i CloudWatch log e i messaggi di errore di Amazon. Per informazioni sugli strumenti di monitoraggio forniti dall'intelligenza artificiale, consulta SageMaker . Monitoraggio AWS delle risorse in Amazon SageMaker AI

Utilizzo di parametri per monitorare i modelli multicontainer

Per monitorare i modelli multi-container in Inference Pipelines, usa Amazon. CloudWatch CloudWatchraccoglie dati grezzi e li trasforma in metriche leggibili e quasi in tempo reale. SageMaker I job e gli endpoint di formazione basati sull'intelligenza artificiale scrivono CloudWatch metriche e registri nel namespace. AWS/SageMaker

Le seguenti tabelle elencano i parametri e le dimensioni per gli elementi seguenti:

-

Invocazioni dell'endpoint

-

Processi di addestramento, processi di trasformazione in batch e istanze di endpoint

Una dimensione è una name/value coppia che identifica in modo univoco una metrica. Puoi assegnare a un parametro fino a 10 dimensioni. Per ulteriori informazioni sul monitoraggio con CloudWatch, vedere. Metriche di Amazon SageMaker AI in Amazon CloudWatch

Parametri di invocazione dell'endpoint

Lo spazio dei nomi AWS/SageMaker include i seguenti parametri di richiesta dalle chiamate a InvokeEndpoint.

I parametri sono segnalati a intervalli di 1 minuto.

| Metrica | Description |

|---|---|

Invocation4XXErrors |

Numero di richieste Unità: nessuna Statistiche valide: |

Invocation5XXErrors |

Numero di richieste Unità: nessuna Statistiche valide: |

Invocations |

Richieste Per ottenere il numero totale di richieste inviate a un endpoint di un modello, utilizza la statistica Unità: nessuna Statistiche valide: |

InvocationsPerInstance |

Il numero di invocazioni degli endpoint inviate a un modello, normalizzato da in ciascuna. Unità: nessuna Statistiche valide: |

ModelLatency |

Il tempo richiesto dal modello o dai modelli per rispondere. Questo include il tempo richiesto per inviare la richiesta, recuperare la risposta dal container di modello e completare l'inferenza nel container. ModelLatency è il tempo totale impiegato da tutti i container in una pipeline di inferenza.Unità: microsecondi Statistiche valide: |

OverheadLatency |

Il tempo aggiunto al tempo impiegato per rispondere a una richiesta del cliente da parte di SageMaker AI for overhead. Unità: microsecondi Statistiche valide: |

ContainerLatency |

Il tempo impiegato da un contenitore Inference Pipelines per rispondere come visualizzato dall'IA. SageMaker ContainerLatencyinclude il tempo impiegato per inviare la richiesta, recuperare la risposta dal contenitore del modello e completare l'inferenza nel contenitore.Unità: microsecondi Statistiche valide: |

Dimensioni dei parametri di invocazione dell'endpoint

| Dimensione | Description |

|---|---|

EndpointName, VariantName, ContainerName |

Filtra i parametri di invocazione dell'endpoint per un |

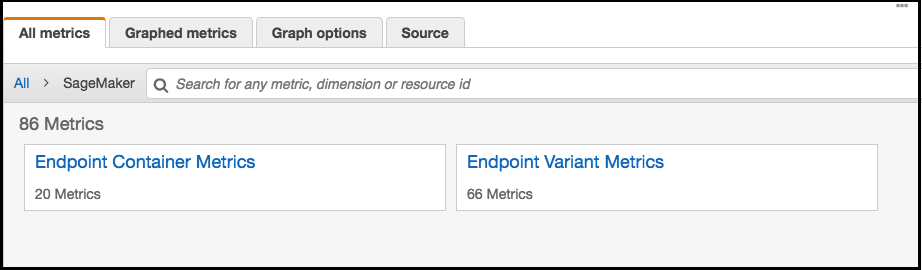

Per un endpoint della pipeline di inferenza, CloudWatch elenca le metriche di latenza per contenitore nel tuo account come Endpoint Container Metrics e Endpoint Variant Metrics nello spazio dei nomi AI, come segue. SageMaker Il parametro ContainerLatency viene visualizzato solo per pipeline di inferenza.

Per ogni endpoint e ogni container, i parametri di latenza visualizzano i nomi di container, endpoint, variante e metrica.

Parametri delle istanze endpoint, dei processi di addestramento e dei processi di trasformazione in batch

Gli spazi dei nomi /aws/sagemaker/TrainingJobs, /aws/sagemaker/TransformJobs e /aws/sagemaker/Endpoints includono i seguenti parametri per i processi di addestramento e le istanze endpoint.

I parametri sono segnalati a intervalli di 1 minuto.

| Metrica | Description |

|---|---|

CPUUtilization |

Percentuale di unità CPU utilizzate dai container in esecuzione su un'istanza. Il valore varia dallo 0% al 100% e viene moltiplicato per il numero di. CPUs Ad esempio, se ce ne sono quattro CPUs, Per i processi di addestramento, Per i processi di trasformazione in batch, Per modelli multi-container, Per le varianti di endpoint, Unità: percentuale |

MemoryUtilization |

Percentuale di memoria utilizzata dai container in esecuzione su un'istanza. Questo valore è compreso tra 0% e 100%. Per i processi di addestramento, Per i processi di trasformazione in batch, MemoryUtilization è la somma della memoria utilizzata da tutti i container in esecuzione sull'istanza.Per le varianti di endpoint, Unità: percentuale |

GPUUtilization |

La percentuale di unità GPU utilizzate dai contenitori in esecuzione su un'istanza. Per i processi di addestramento, Per i processi di trasformazione in batch, Per modelli multi-container, Per le varianti di endpoint, Unità: percentuale |

GPUMemoryUtilization |

La percentuale di memoria GPU utilizzata dai contenitori in esecuzione su un'istanza. GPUMemoryL'utilizzo varia dallo 0% al 100% e viene moltiplicato per il numero di. GPUs Ad esempio, se ce ne sono quattro GPUs, Per i processi di addestramento, Per i processi di trasformazione in batch, Per i modelli multi-container, Per le versioni di endpoint, Unità: percentuale |

DiskUtilization |

La percentuale di spazio su disco utilizzata dai contenitori in esecuzione su un'istanza. DiskUtilization varia dallo 0% al 100%. Questo parametro non è supportato per i processi di trasformazione in batch. Per i processi di addestramento, Per le varianti di endpoint, Unità: percentuale |

Dimensioni dei parametri delle istanze dell'endpoint, dei processi di addestramento e dei processi di trasformazione in batch

| Dimensione | Description |

|---|---|

Host |

Per i processi di addestramento, Per i processi di trasformazione in batch, Per gli endpoint, |

Per aiutarti a eseguire il debug dei processi di formazione, degli endpoint e delle configurazioni del ciclo di vita delle istanze notebook, l' SageMaker IA invia anche tutto ciò che un contenitore di algoritmi, un contenitore modello o una configurazione del ciclo di vita di un'istanza notebook invia ad Amazon Logs. stdout stderr CloudWatch Puoi utilizzare queste informazioni per il debug e l'analisi dell'avanzamento.

Utilizzo di log per monitorare una pipeline di inferenza

La tabella seguente elenca i gruppi di log e i flussi di log che SageMaker AI. invia ad Amazon. CloudWatch

Un flusso di log è una sequenza di eventi di log che condividono la stessa origine. Ogni fonte separata di log in CloudWatch costituisce un flusso di log separato. Un gruppo di log è un gruppo di flussi di log che condividono le stesse impostazioni di conservazione, monitoraggio e controllo degli accessi.

Log

| Nome del gruppo di log | Nome del flusso di log |

|---|---|

/aws/sagemaker/TrainingJobs |

|

/aws/sagemaker/Endpoints/[EndpointName] |

|

|

|

|

|

|

|

/aws/sagemaker/NotebookInstances |

|

/aws/sagemaker/TransformJobs |

|

|

|

|

|

|

Nota

SageMaker L'IA crea il gruppo di /aws/sagemaker/NotebookInstances log quando si crea un'istanza di notebook con una configurazione del ciclo di vita. Per ulteriori informazioni, consulta Personalizzazione di un'istanza di SageMaker notebook utilizzando uno script LCC.

Per ulteriori informazioni sulla registrazione SageMaker AI, consulta. CloudWatch Registri per Amazon SageMaker AI